Onderzoekers van de North Carolina State University hebben een nieuwe state-of-the-art methode ontwikkeld om te controleren hoe kunstmatige intelligentie (AI)-systemen beelden creëren. Het werk heeft toepassingen voor velden van autonome robotica tot AI-training.

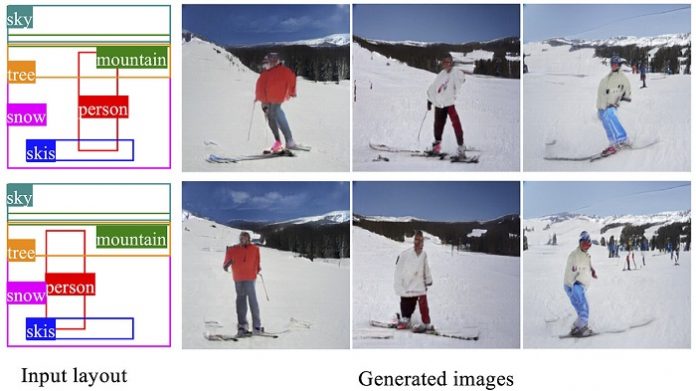

Het gaat om een soort AI-taak genaamd conditional image generation, waarbij AI-systemen beelden creëren die aan een specifieke set voorwaarden voldoen. Een systeem kan bijvoorbeeld worden getraind om originele afbeeldingen van katten of honden te maken, afhankelijk van het dier dat de gebruiker heeft aangevraagd. Meer recente technieken hebben hierop voortgebouwd om voorwaarden met betrekking tot een beeldlay-out op te nemen. Hiermee kunnen gebruikers specificeren welke soorten objecten ze op bepaalde plaatsen op het scherm willen weergeven. De lucht kan bijvoorbeeld in een doos gaan, een boom in een andere doos, een stroom in een aparte doos, enzovoort.

Het nieuwe werk bouwt voort op die technieken om gebruikers meer controle te geven over de resulterende afbeeldingen en om bepaalde kenmerken over een reeks afbeeldingen te behouden.

"Onze aanpak is zeer herconfigureerbaar", zegt Tianfu Wu, co-auteur van een paper over het werk en een assistent-professor computertechnologie bij NC State. “Net als bij eerdere benaderingen, stelt onze gebruikers het systeem in staat om een afbeelding te laten genereren op basis van een specifieke set voorwaarden. Maar die van ons stelt u ook in staat om dat beeld te behouden en eraan toe te voegen. Gebruikers kunnen bijvoorbeeld de AI een bergtafereel laten maken. De gebruikers kunnen dan het systeem skiërs aan die scène laten toevoegen.”

Bovendien stelt de nieuwe aanpak gebruikers in staat om de AI specifieke elementen te laten manipuleren, zodat ze herkenbaar hetzelfde zijn, maar op de een of andere manier zijn verplaatst of veranderd. De AI kan bijvoorbeeld een reeks afbeeldingen maken waarop skiërs zich naar de kijker draaien terwijl ze door het landschap bewegen.

"Een toepassing hiervoor zou zijn om autonome robots te helpen zich 'in te beelden' hoe het eindresultaat eruit zou kunnen zien voordat ze aan een bepaalde taak beginnen", zegt Wu. “Je zou het systeem ook kunnen gebruiken om beelden te genereren voor AI-trainingen. Dus in plaats van afbeeldingen van externe bronnen te verzamelen, zou je dit systeem kunnen gebruiken om afbeeldingen te maken voor het trainen van andere AI-systemen.”

De onderzoekers testten hun nieuwe aanpak met behulp van de COCO-Stuff dataset en de Visual Genome dataset. Gebaseerd op standaardmetingen van beeldkwaliteit, presteerde de nieuwe aanpak beter dan de eerdere state-of-the-art technieken voor beeldcreatie.

"Onze volgende stap is om te kijken of we dit werk kunnen uitbreiden naar video en driedimensionale afbeeldingen", zegt Wu.

Training voor de nieuwe aanpak vereist behoorlijk wat rekenkracht; de onderzoekers gebruikten een 4-GPU-werkstation. Het implementeren van het systeem is echter minder rekenkundig duur.

“Die hebben we gevonden GPU geeft je bijna realtime snelheid”, zegt Wu