Knowles bringt Raspberry Pi Dev Kit auf den Markt, um die Sprachintegration zu ermöglichen

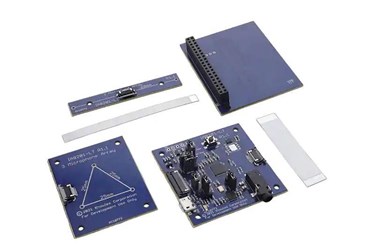

Knowles stellt das AISonic IA8201 Raspberry Pi Development Kit zur Verfügung, das Sprach-, Audio-Edge-Processing- und Machine Learning (ML)-Hörfunktionen für Geräte und Systeme in einer Reihe verschiedener Branchen bietet.

Produktdesigner und Ingenieure haben nun Zugriff auf ein einziges Tool, um Design, Entwicklung und Tests zu optimieren Technologie Dies wird dazu beitragen, die Sprach- und Audiointegration in ihren jeweiligen Branchen zu erweitern.

„Knowles hat dieses Kit so konzipiert, dass es Produktdesignern die einfachste und schnellste Möglichkeit bietet, neue Innovationen zu prototypieren, um aufkommende Anwendungsfälle zu adressieren, einschließlich kontextabhängiger Stimme, ML-Hören und Echtzeit-Audioverarbeitung, die flexible Entwicklungstools erfordern, um den Designprozess zu beschleunigen. Entwicklungskosten zu minimieren und neue technologische Fortschritte zu nutzen“, sagte Vikram Shrivastava, Senior Director, IoT Marketing bei Knowles. „Durch die Auswahl von Raspberry Pi als Systemhost eröffnen wir der größten Community von Systementwicklern, die eine Linux- oder Android-Umgebung bevorzugen, die Möglichkeit, Sprache und ML hinzuzufügen.“

Das Kit basiert auf dem Knowles AISonic IA8201 Audio Edge Processor OpenDSP für extrem geringen Stromverbrauch und hohe Leistung. Der Audio-Edge-Prozessor kombiniert zwei auf Tensilica basierende, audiozentrische DSP-Kerne; eine für Hochleistungs-Computing- und KI/ML-Anwendungen und die andere für sehr energiesparende, immer aktive Verarbeitung von Sensoreingaben.

Der IA8201 verfügt über 1 MB RAM auf dem Chip, der eine hohe Bandbreitenverarbeitung von fortschrittlichen, kontextabhängigen ML-Anwendungsfällen und Speicher für mehrere Algorithmen für eine optimale Benutzererfahrung ermöglicht.

Unter Verwendung der offenen DSP-Plattform enthält das Kit eine Bibliothek mit integrierten Audioalgorithmen und AI/ML-Bibliotheken. Farfield-Audioanwendungen können mit der verfügbaren Sprachweckfunktion mit extrem geringem Stromverbrauch, Beamforming, benutzerdefinierten Schlüsselwörtern und Eliminierung von Hintergrundgeräuschen von Knowles-Algorithmuspartnern aus dem intelligenten Sprachökosystem wie Amazon Alexa, Sensory, Retune und Alango erstellt werden, die eine breite Palette von Sprach- und Audioanpassung.

Das Kit enthält auch TensorFlow Lite-Micro SDK für schnelles Prototyping und Produktentwicklung für KI/ML-Anwendungen. Dies ermöglicht die Portierung von Modellen, die in größeren Cloud-Tensor-Flow-Frameworks entwickelt wurden, auf eine eingebettete Plattform in der Regel mit begrenzter Rechenleistung und geringerem Stromverbrauch am Edge, beispielsweise KI-Inferenz-Engines für Branchen wie Industrie und Gewerbe.

Mit Optionen für entweder zwei oder drei vorintegrierte Knowles Everest-Mikrofone, je nach Produktanforderungen, enthält das Kit zwei Mikrofon-Array-Platinen, um die Auswahl der geeigneten Algorithmuskonfigurationen für die Endanwendung zu erleichtern.

Laut Knowles erhalten OEMs durch das Angebot integrierter Mikrofonarrays, die die Audio- und Sprachfunktionen des IA8201 DSP unterstützen, Zugang zu einer hochwertigen, leistungsstarken All-in-One-Entwicklungslösung von einem einzigen Anbieter.

Entwicklersupport ist über das Knowles Solutions Portal für Konfigurationstools, Firmware und Algorithmen verfügbar, die standardmäßig mit dem Kit geliefert werden und ein vollständiges Prototyping, Design und Debugging ermöglichen.