Knowles lancia il Raspberry Pi Dev Kit per abilitare l'integrazione vocale

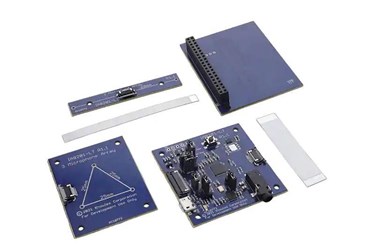

Knowles sta rendendo disponibile il kit di sviluppo Raspberry Pi AISonic IA8201 che offre capacità di ascolto vocale, audio edge processing e machine learning (ML) a dispositivi e sistemi in una vasta gamma di settori diversi.

I progettisti e gli ingegneri di prodotto avranno ora accesso a un unico strumento per semplificare la progettazione, lo sviluppo e il test la tecnologia ciò contribuirà ad estendere l’integrazione vocale e audio nei rispettivi settori.

“Knowles ha progettato questo kit per essere il modo più semplice e veloce per i progettisti di prodotti di prototipare nuove innovazioni per affrontare casi d'uso emergenti tra cui voce contestualmente consapevole, ascolto ML ed elaborazione audio in tempo reale, che richiedono strumenti di sviluppo flessibili per accelerare il processo di progettazione, ridurre al minimo i costi di sviluppo e sfruttare i nuovi progressi tecnologici", ha affermato Vikram Shrivastava, senior director, IoT Marketing di Knowles. "Selezionando Raspberry Pi come host di sistema, stiamo aprendo la possibilità di aggiungere voce e ML alla più grande comunità di sviluppatori di sistemi che preferiscono un ambiente Linux o Android".

Il kit è costruito attorno al Knowles AISonic IA8201 Audio Edge Processor OpenDSP, per bassissima potenza e alte prestazioni. Il processore audio edge combina due core DSP audio-centrici basati su Tensilica; uno per l'elaborazione ad alta potenza e le applicazioni AI/ML e l'altro per l'elaborazione a bassissima potenza e sempre attiva degli ingressi dei sensori.

L'IA8201 ha 1 MB di RAM su chip che consente l'elaborazione a larghezza di banda elevata di casi d'uso ML contestualizzati avanzati e sempre attivi e memoria per più algoritmi per un'esperienza utente ottimale.

Utilizzando la piattaforma DSP aperta, il kit include una libreria di algoritmi audio integrati e librerie AI/ML. Le applicazioni audio Farfield possono essere create utilizzando la riattivazione vocale a bassissima potenza, il beamforming, le parole chiave personalizzate, l'eliminazione del rumore di fondo, dai partner di algoritmi Knowles dell'ecosistema vocale intelligente come Amazon Alexa, Sensory, Retune e Alango che supportano un'ampia gamma di personalizzazione della voce e dell'audio.

Il kit include anche TensorFlow Lite-Micro SDK per la prototipazione rapida e lo sviluppo di prodotti per applicazioni AI/ML. Ciò consente il porting di modelli sviluppati in framework Tensor Flow cloud più grandi su una piattaforma incorporata solitamente con elaborazione limitata e consumo energetico inferiore all'edge, ad esempio motori di inferenza AI per verticali come industriale e commerciale.

Con opzioni per due o tre microfoni Knowles Everest preintegrati in base alle esigenze del prodotto, il kit include due schede array di microfoni per aiutare a selezionare le configurazioni di algoritmi appropriate per l'applicazione finale.

Secondo Knowles, offrendo array di microfoni integrati che supportano le funzionalità audio e voce sul DSP IA8201, gli OEM avranno accesso a una soluzione di sviluppo all-in-one di alta qualità e ad alte prestazioni da un unico fornitore.

Il supporto per gli sviluppatori è disponibile tramite il portale delle soluzioni Knowles per strumenti di configurazione, firmware e algoritmi forniti di serie con il kit, consentendo la prototipazione, la progettazione e il debug completi.