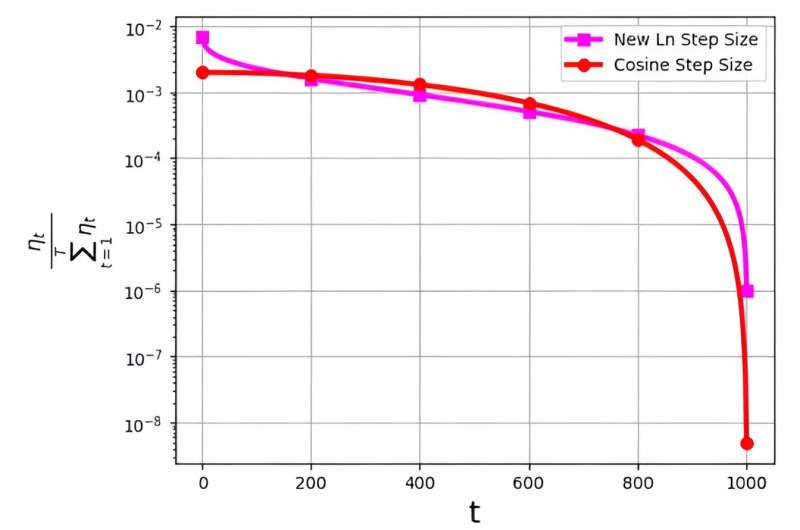

يلعب حجم الخطوة، والذي يشار إليه غالبًا باسم معدل التعلم، دورًا محوريًا في تحسين كفاءة خوارزمية النسب التدرج العشوائي (SGD). في الآونة الأخيرة، ظهرت استراتيجيات متعددة لحجم الخطوات لتعزيز أداء SGD. ومع ذلك، يرتبط التحدي الكبير المرتبط بأحجام الخطوات هذه بتوزيع احتمالاتها، والذي يشار إليه بـ ηt/ΣTر = 1ج.

وقد لوحظ هذا التوزيع لتجنب تعيين قيم صغيرة للغاية للتكرارات النهائية. على سبيل المثال، فإن حجم خطوة جيب التمام المستخدم على نطاق واسع، على الرغم من فعاليته في الممارسة العملية، يواجه هذه المشكلة عن طريق تعيين قيم توزيع احتمالية منخفضة جدًا للتكرارات الأخيرة.

ولمواجهة هذا التحدي، قام فريق بحثي بقيادة م. سهيل شماعي بنشر بحثهم في حدود علوم الكمبيوتر.

يقدم الفريق حجم خطوة لوغاريتمية جديدة لنهج SGD. لقد أثبت حجم الخطوة الجديد فعاليته بشكل خاص أثناء التكرارات النهائية، حيث يتمتع باحتمالية اختيار أعلى بكثير مقارنة بحجم خطوة جيب التمام التقليدية.

ونتيجة لذلك، تتجاوز طريقة حجم الخطوة الجديدة أداء طريقة حجم خطوة جيب التمام في هذه التكرارات الختامية الحاسمة، مستفيدة من احتمالية اختيارها المتزايدة كحل محدد. النتائج الرقمية التي تم الحصول عليها بمثابة شهادة على كفاءة حجم الخطوة المقترحة حديثا، لا سيما في مجموعات البيانات FashionMinst، CIFAR10، وCIFAR100.

بالإضافة إلى ذلك، أظهر حجم الخطوة اللوغاريتمية الجديد تحسينات ملحوظة في دقة الاختبار، مما أدى إلى زيادة بنسبة 0.9% لمجموعة بيانات CIFAR100 عند استخدامها مع نموذج الشبكة العصبية التلافيفية (CNN).