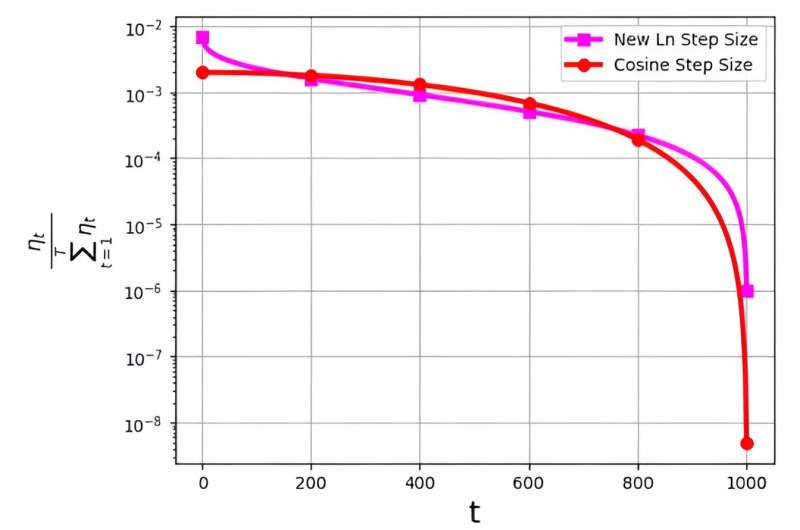

学習率と呼ばれることが多いステップ サイズは、確率的勾配降下法 (SGD) アルゴリズムの効率を最適化する上で極めて重要な役割を果たします。最近では、SGD のパフォーマンスを向上させるために、複数のステップ サイズ戦略が登場しています。ただし、これらのステップ サイズに関連する重大な課題は、ηt/Σ として示される確率分布に関連しています。Tt = 1ηt 。

この分布は、最終反復に非常に小さな値が割り当てられることを避けるために観察されています。たとえば、広く使用されているコサイン ステップ サイズは、実際には効果的ですが、最後の反復に非常に低い確率分布値を割り当てることによってこの問題に遭遇します。

この課題に対処するために、M. Soheil Shamaee 率いる研究チームは研究結果を コンピューターサイエンスのフロンティア.

チームは、SGD アプローチに新しい対数ステップ サイズを導入しました。この新しいステップ サイズは、従来のコサイン ステップ サイズと比較して、選択の確率が大幅に高くなる最終反復時に特に効果的であることが証明されています。

その結果、新しいステップ サイズ手法は、これらの重要な最終反復においてコサイン ステップ サイズ手法のパフォーマンスを上回り、選択されたソリューションとして選択される可能性が高まるという恩恵を受けています。得られた数値結果は、特に FashionMinst、CIFAR10、および CIFAR100 データセットにおいて、新しく提案されたステップ サイズの効率性の証拠として役立ちます。

さらに、新しい対数ステップ サイズによりテスト精度が大幅に向上し、畳み込みニューラル ネットワーク (CNN) モデルと併用した場合、CIFAR0.9 データセットで 100% の向上が達成されました。