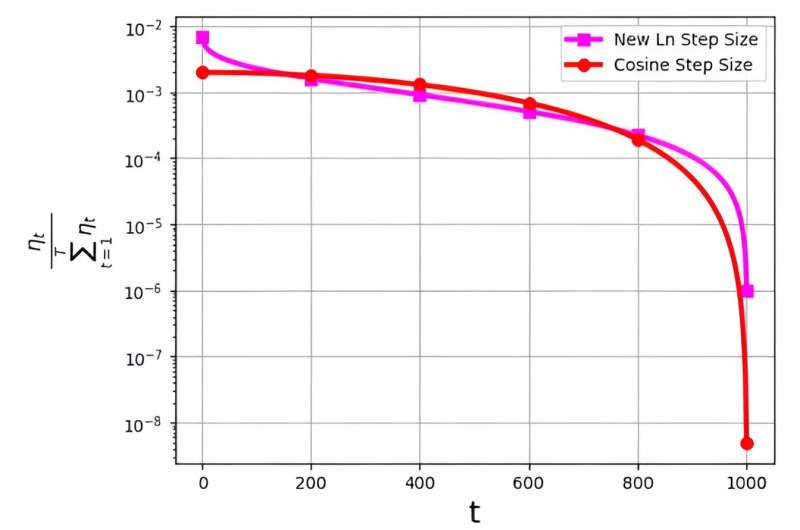

Ukuran langkah, sering disebut sebagai kecepatan pembelajaran, memainkan peran penting dalam mengoptimalkan efisiensi algoritma penurunan gradien stokastik (SGD). Belakangan ini, berbagai strategi ukuran langkah telah muncul untuk meningkatkan kinerja SGD. Namun, tantangan signifikan yang terkait dengan ukuran langkah ini terkait dengan distribusi probabilitasnya, yang dinotasikan sebagai ηt/ΣTt = 1ηt.

Distribusi ini telah diamati untuk menghindari pemberian nilai yang terlalu kecil pada iterasi akhir. Misalnya, ukuran langkah kosinus yang banyak digunakan, meskipun efektif dalam praktiknya, mengatasi masalah ini dengan menetapkan nilai distribusi probabilitas yang sangat rendah pada iterasi terakhir.

Untuk mengatasi tantangan ini, tim peneliti yang dipimpin oleh M. Soheil Shamaee mempublikasikan penelitiannya di Perbatasan Ilmu Komputer.

Tim memperkenalkan ukuran langkah logaritmik baru untuk pendekatan SGD. Ukuran langkah baru ini telah terbukti sangat efektif selama iterasi akhir, dimana ia mempunyai kemungkinan seleksi yang jauh lebih tinggi dibandingkan dengan ukuran langkah kosinus konvensional.

Hasilnya, metode ukuran langkah baru ini melampaui kinerja metode ukuran langkah kosinus dalam iterasi penutup kritis ini, sehingga mendapatkan manfaat dari peningkatan kemungkinan terpilihnya metode tersebut sebagai solusi terpilih. Hasil numerik yang diperoleh menjadi bukti efisiensi ukuran langkah yang baru diusulkan, khususnya pada kumpulan data FashionMinst, CIFAR10, dan CIFAR100.

Selain itu, ukuran langkah logaritmik baru telah menunjukkan peningkatan luar biasa dalam akurasi pengujian, mencapai peningkatan sebesar 0.9% untuk kumpulan data CIFAR100 saat digunakan dengan model jaringan saraf konvolusional (CNN).