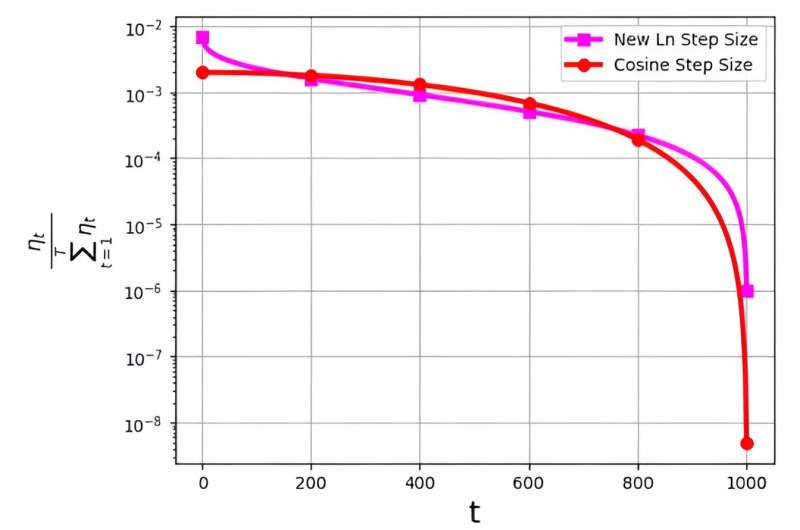

O tamanho do passo, muitas vezes referido como taxa de aprendizagem, desempenha um papel fundamental na otimização da eficiência do algoritmo de descida gradiente estocástica (SGD). Nos últimos tempos, surgiram múltiplas estratégias de tamanho de passo para melhorar o desempenho do SGD. No entanto, um desafio significativo associado a estes tamanhos de passo está relacionado com a sua distribuição de probabilidade, denotada como ηt/ΣTt = 1ηt.

Esta distribuição foi observada para evitar a atribuição de valores excessivamente pequenos às iterações finais. Por exemplo, o tamanho do passo do cosseno amplamente utilizado, embora eficaz na prática, enfrenta esse problema ao atribuir valores de distribuição de probabilidade muito baixos às últimas iterações.

Para enfrentar este desafio, uma equipe de pesquisa liderada por M. Soheil Shamaee publicou sua pesquisa em Fronteiras da Ciência da Computação.

A equipe introduz um novo tamanho de passo logarítmico para a abordagem SGD. Este novo tamanho de passo provou ser particularmente eficaz durante as iterações finais, onde desfruta de uma probabilidade de seleção significativamente maior em comparação com o tamanho de passo de cosseno convencional.

Como resultado, o novo método do tamanho do passo supera o desempenho do método do tamanho do passo do cosseno nestas iterações finais críticas, beneficiando-se da sua maior probabilidade de ser escolhido como a solução selecionada. Os resultados numéricos obtidos servem como prova da eficiência do tamanho do passo recentemente proposto, particularmente nos conjuntos de dados FashionMinst, CIFAR10 e CIFAR100.

Além disso, o novo tamanho do passo logarítmico mostrou melhorias notáveis na precisão do teste, alcançando um aumento de 0.9% para o conjunto de dados CIFAR100 quando utilizado com um modelo de rede neural convolucional (CNN).