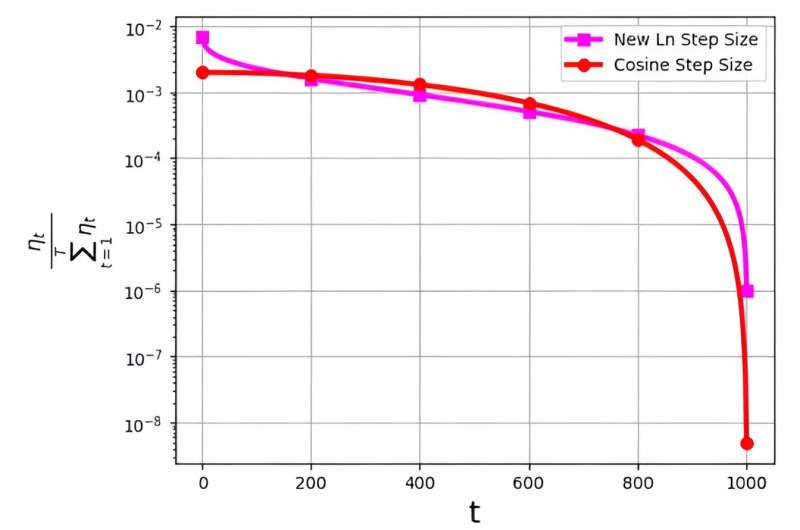

ขนาดขั้นตอนซึ่งมักเรียกว่าอัตราการเรียนรู้ มีบทบาทสำคัญในการปรับประสิทธิภาพของอัลกอริทึม Stochastic Gradence Descent (SGD) ให้เหมาะสม ในช่วงไม่กี่ครั้งที่ผ่านมา กลยุทธ์ขนาดขั้นตอนต่างๆ ได้เกิดขึ้นเพื่อเพิ่มประสิทธิภาพ SGD อย่างไรก็ตาม ความท้าทายที่สำคัญที่เกี่ยวข้องกับขนาดขั้นตอนเหล่านี้เกี่ยวข้องกับการแจกแจงความน่าจะเป็น ซึ่งแสดงเป็น ηt/ΣTt = 1ηt

การกระจายนี้ได้รับการสังเกตเพื่อหลีกเลี่ยงการกำหนดค่าที่เล็กเกินไปให้กับการวนซ้ำครั้งสุดท้าย ตัวอย่างเช่น ขนาดขั้นตอนโคไซน์ที่ใช้กันอย่างแพร่หลาย แม้ว่าจะมีประสิทธิภาพในทางปฏิบัติ แต่ก็ประสบปัญหานี้โดยการกำหนดค่าการแจกแจงความน่าจะเป็นที่ต่ำมากให้กับการวนซ้ำครั้งล่าสุด

เพื่อจัดการกับความท้าทายนี้ ทีมวิจัยที่นำโดย M. Soheil Shamaee ได้เผยแพร่งานวิจัยของพวกเขาใน พรมแดนของวิทยาการคอมพิวเตอร์.

ทีมงานแนะนำขนาดขั้นลอการิทึมใหม่สำหรับแนวทาง SGD ขนาดขั้นตอนใหม่นี้ได้รับการพิสูจน์แล้วว่ามีประสิทธิภาพโดยเฉพาะอย่างยิ่งในระหว่างการวนซ้ำขั้นสุดท้าย ซึ่งมีความน่าจะเป็นในการเลือกที่สูงขึ้นอย่างมากเมื่อเปรียบเทียบกับขนาดขั้นตอนโคไซน์ทั่วไป

ด้วยเหตุนี้ วิธีการกำหนดขนาดขั้นตอนใหม่จึงเหนือกว่าประสิทธิภาพของวิธีกำหนดขนาดขั้นตอนโคไซน์ในการวนซ้ำเพื่อสรุปที่สำคัญเหล่านี้ โดยได้รับประโยชน์จากความเป็นไปได้ที่เพิ่มขึ้นในการได้รับเลือกเป็นโซลูชันที่เลือก ผลลัพธ์เชิงตัวเลขที่ได้รับเป็นข้อพิสูจน์ถึงประสิทธิภาพของขนาดขั้นตอนที่เสนอใหม่ โดยเฉพาะอย่างยิ่งในชุดข้อมูล FashionMinst, CIFAR10 และ CIFAR100

นอกจากนี้ ขนาดขั้นลอการิทึมใหม่ยังแสดงให้เห็นถึงการปรับปรุงความแม่นยำในการทดสอบอย่างน่าทึ่ง โดยเพิ่มขึ้น 0.9% สำหรับชุดข้อมูล CIFAR100 เมื่อใช้กับโมเดลเครือข่ายประสาทเทียม (CNN)