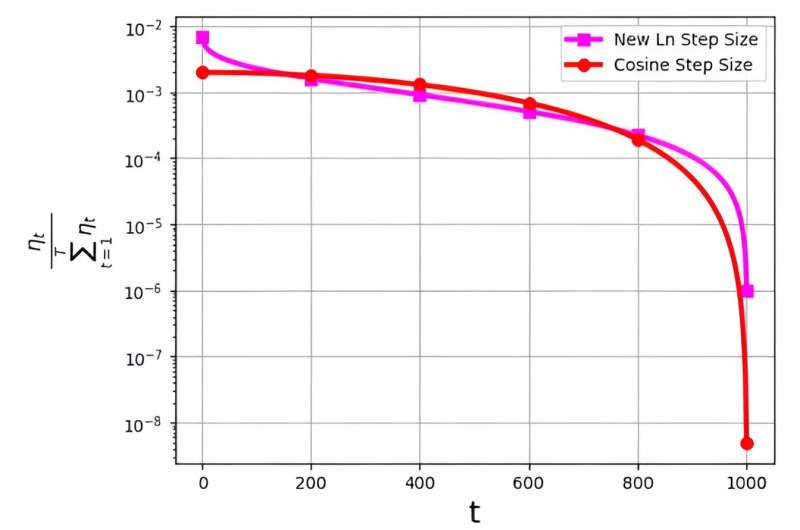

흔히 학습률이라고도 하는 단계 크기는 확률적 경사하강법(SGD) 알고리즘의 효율성을 최적화하는 데 중추적인 역할을 합니다. 최근에는 SGD 성능을 향상시키기 위한 여러 단계 크기 전략이 등장했습니다. 그러나 이러한 단계 크기와 관련된 중요한 문제는 θt/Σ로 표시되는 확률 분포와 관련이 있습니다.Tt = 1θt .

이 분포는 최종 반복에 지나치게 작은 값을 할당하는 것을 방지하기 위해 관찰되었습니다. 예를 들어, 널리 사용되는 코사인 단계 크기는 실제로는 효과적이지만 마지막 반복에 매우 낮은 확률 분포 값을 할당하여 이 문제에 직면합니다.

이 문제를 해결하기 위해 M. Soheil Shamaee가 이끄는 연구팀은 연구 결과를 다음과 같이 발표했습니다. 컴퓨터 과학의 개척지.

팀은 SGD 접근 방식에 대한 새로운 로그 단계 크기를 도입했습니다. 이 새로운 단계 크기는 최종 반복 중에 특히 효과적인 것으로 입증되었으며, 여기서 기존 코사인 단계 크기에 비해 선택 가능성이 훨씬 더 높습니다.

결과적으로 새로운 단계 크기 방법은 이러한 중요한 최종 반복에서 코사인 단계 크기 방법의 성능을 능가하여 선택된 솔루션으로 선택될 가능성이 높아진다는 이점을 얻습니다. 얻은 수치 결과는 특히 FashionMinst, CIFAR10 및 CIFAR100 데이터세트에서 새로 제안된 단계 크기의 효율성을 입증하는 역할을 합니다.

또한 새로운 로그 단계 크기는 CNN(컨볼루션 신경망) 모델과 함께 활용했을 때 CIFAR0.9 데이터 세트의 100% 증가를 달성하여 테스트 정확도가 크게 향상되었습니다.