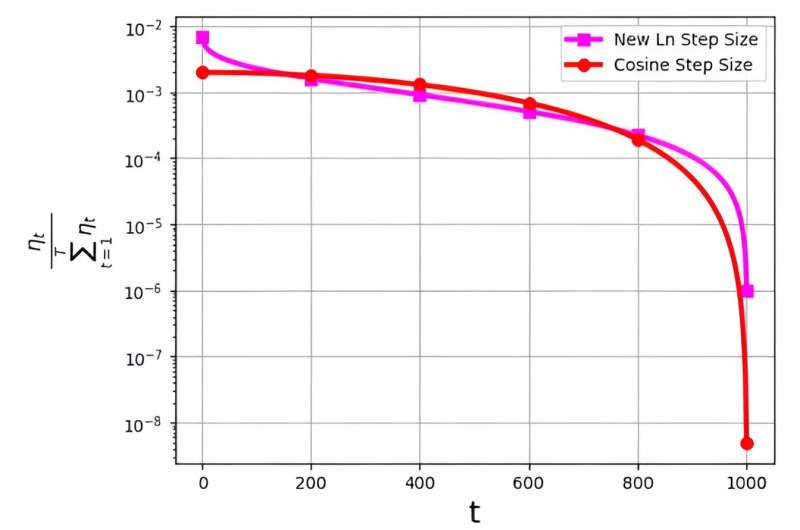

Размер шага, часто называемый скоростью обучения, играет ключевую роль в оптимизации эффективности алгоритма стохастического градиентного спуска (SGD). В последнее время появились стратегии с несколькими размерами шагов для повышения производительности SGD. Однако значительная проблема, связанная с этими размерами шагов, связана с их распределением вероятностей, обозначаемым как ηt/Σ.Tт = 1ηт.

Было замечено, что такое распределение позволяет избежать присвоения слишком малых значений финальным итерациям. Например, широко используемый размер косинусного шага, хотя и эффективен на практике, сталкивается с этой проблемой, присваивая последним итерациям очень низкие значения распределения вероятностей.

Чтобы решить эту проблему, исследовательская группа под руководством М. Сохейла Шамаи опубликовала свое исследование в журнале Границы информатики.

Команда представляет новый логарифмический размер шага для подхода SGD. Этот новый размер шага оказался особенно эффективным на последних итерациях, где он имеет значительно более высокую вероятность выбора по сравнению с обычным размером косинусного шага.

В результате новый метод размера шага превосходит производительность метода размера косинусного шага на этих критических заключительных итерациях, получая выгоду от их повышенной вероятности быть выбранным в качестве выбранного решения. Полученные численные результаты служат свидетельством эффективности недавно предложенного размера шага, особенно в наборах данных FashionMinst, CIFAR10 и CIFAR100.

Кроме того, новый размер логарифмического шага продемонстрировал значительное улучшение точности теста, достигнув увеличения на 0.9% для набора данных CIFAR100 при использовании с моделью сверточной нейронной сети (CNN).