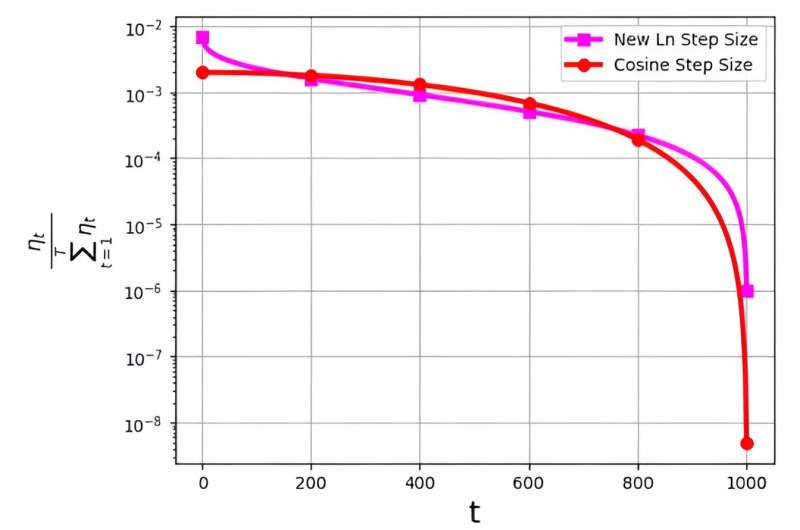

Die Schrittgröße, oft auch als Lernrate bezeichnet, spielt eine entscheidende Rolle bei der Optimierung der Effizienz des stochastischen Gradientenabstiegs (SGD)-Algorithmus. In jüngster Zeit wurden mehrere Schrittgrößenstrategien zur Verbesserung der SGD-Leistung entwickelt. Eine erhebliche Herausforderung im Zusammenhang mit diesen Schrittgrößen hängt jedoch mit ihrer Wahrscheinlichkeitsverteilung zusammen, die als ηt/Σ bezeichnet wirdTt = 1ηt .

Diese Verteilung wurde beobachtet, um zu vermeiden, dass den endgültigen Iterationen übermäßig kleine Werte zugewiesen werden. Die weit verbreitete Kosinus-Schrittweite ist beispielsweise in der Praxis zwar effektiv, begegnet diesem Problem jedoch dadurch, dass den letzten Iterationen sehr niedrige Wahrscheinlichkeitsverteilungswerte zugewiesen werden.

Um dieser Herausforderung zu begegnen, veröffentlichte ein Forschungsteam unter der Leitung von M. Soheil Shamaee seine Forschung in Grenzen der Informatik.

Das Team führt eine neue logarithmische Schrittgröße für den SGD-Ansatz ein. Diese neue Schrittweite hat sich in den letzten Iterationen als besonders effektiv erwiesen, wo sie im Vergleich zur herkömmlichen Cosinus-Schrittweite eine deutlich höhere Auswahlwahrscheinlichkeit aufweist.

Dadurch übertrifft die neue Schrittweitenmethode die Leistung der Cosinus-Schrittweitenmethode in diesen kritischen abschließenden Iterationen und profitiert von ihrer erhöhten Wahrscheinlichkeit, als ausgewählte Lösung ausgewählt zu werden. Die erhaltenen numerischen Ergebnisse sind ein Beweis für die Effizienz der neu vorgeschlagenen Schrittgröße, insbesondere für die Datensätze FashionMinst, CIFAR10 und CIFAR100.

Darüber hinaus hat die neue logarithmische Schrittgröße bemerkenswerte Verbesserungen der Testgenauigkeit gezeigt und eine Steigerung von 0.9 % für den CIFAR100-Datensatz erreicht, wenn er mit einem Convolutional Neural Network (CNN)-Modell verwendet wird.