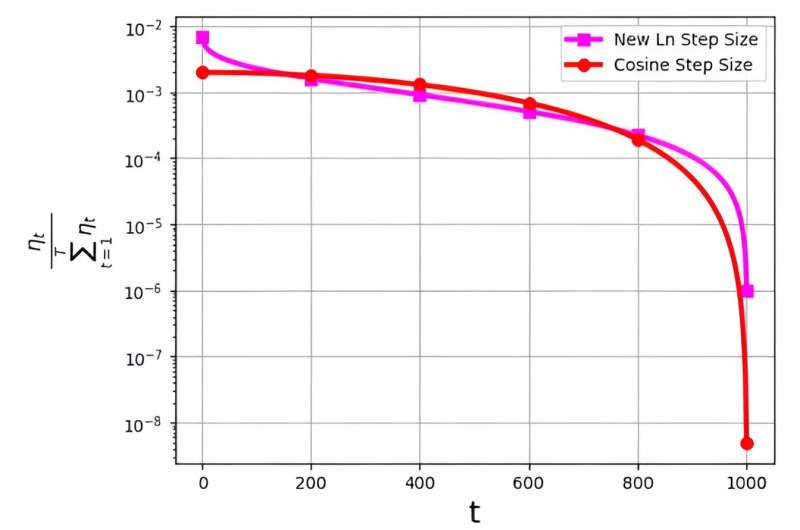

El tamaño del paso, a menudo denominado tasa de aprendizaje, juega un papel fundamental en la optimización de la eficiencia del algoritmo de descenso de gradiente estocástico (SGD). En los últimos tiempos, han surgido múltiples estrategias de tamaño de paso para mejorar el desempeño de SGD. Sin embargo, un desafío importante asociado con estos tamaños de paso está relacionado con su distribución de probabilidad, denotada como ηt/ΣTt = 1ηt.

Se ha observado esta distribución para evitar asignar valores excesivamente pequeños a las iteraciones finales. Por ejemplo, el tamaño de paso del coseno ampliamente utilizado, si bien es eficaz en la práctica, enfrenta este problema al asignar valores de distribución de probabilidad muy bajos a las últimas iteraciones.

Para abordar este desafío, un equipo de investigación dirigido por M. Soheil Shamaee publicó su investigación en Fronteras de la informática.

El equipo introduce un nuevo tamaño de paso logarítmico para el enfoque SGD. Este nuevo tamaño de paso ha demostrado ser particularmente efectivo durante las iteraciones finales, donde disfruta de una probabilidad de selección significativamente mayor en comparación con el tamaño de paso del coseno convencional.

Como resultado, el nuevo método de tamaño de paso supera el rendimiento del método de tamaño de paso del coseno en estas iteraciones finales críticas, beneficiándose de su mayor probabilidad de ser elegido como la solución seleccionada. Los resultados numéricos obtenidos sirven como testimonio de la eficiencia del tamaño de paso recientemente propuesto, particularmente en los conjuntos de datos FashionMinst, CIFAR10 y CIFAR100.

Además, el nuevo tamaño de paso logarítmico ha mostrado mejoras notables en la precisión de las pruebas, logrando un aumento del 0.9 % para el conjunto de datos CIFAR100 cuando se utiliza con un modelo de red neuronal convolucional (CNN).