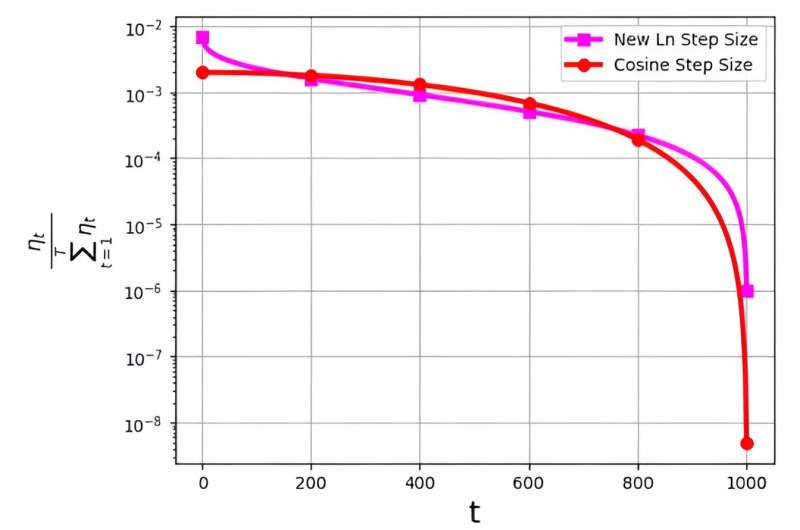

La taille du pas, souvent appelée taux d'apprentissage, joue un rôle central dans l'optimisation de l'efficacité de l'algorithme de descente de gradient stochastique (SGD). Ces derniers temps, des stratégies à plusieurs étapes ont émergé pour améliorer les performances de SGD. Cependant, un défi important associé à ces tailles de pas est lié à leur distribution de probabilité, notée ηt/Σ.Tt = 1ηt.

Cette distribution a été observée pour éviter d'attribuer des valeurs excessivement petites aux itérations finales. Par exemple, le pas de cosinus largement utilisé, bien qu'efficace dans la pratique, résout ce problème en attribuant des valeurs de distribution de probabilité très faibles aux dernières itérations.

Pour relever ce défi, une équipe de recherche dirigée par M. Soheil Shamaee a publié ses recherches dans Frontières de l'informatique.

L’équipe introduit une nouvelle taille de pas logarithmique pour l’approche SGD. Cette nouvelle taille de pas s'est avérée particulièrement efficace lors des itérations finales, où elle bénéficie d'une probabilité de sélection nettement plus élevée par rapport à la taille de pas cosinus conventionnelle.

En conséquence, la nouvelle méthode de taille de pas surpasse les performances de la méthode de taille de pas cosinus dans ces itérations finales critiques, bénéficiant de leur probabilité accrue d’être choisie comme solution sélectionnée. Les résultats numériques obtenus témoignent de l’efficacité de la nouvelle taille de pas proposée, en particulier sur les ensembles de données FashionMinst, CIFAR10 et CIFAR100.

De plus, la nouvelle taille de pas logarithmique a montré des améliorations remarquables dans la précision des tests, atteignant une augmentation de 0.9 % pour l'ensemble de données CIFAR100 lorsqu'il est utilisé avec un modèle de réseau neuronal convolutif (CNN).