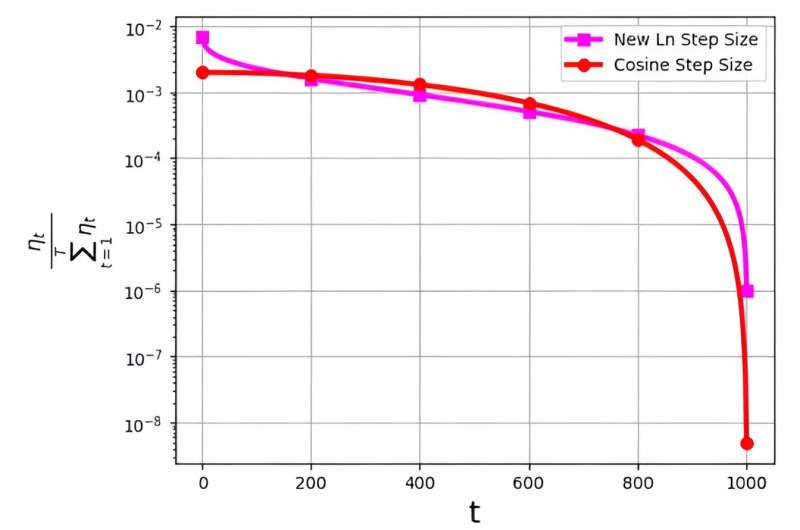

De stapgrootte, vaak de leersnelheid genoemd, speelt een cruciale rol bij het optimaliseren van de efficiëntie van het stochastische gradiëntafdalingalgoritme (SGD). De afgelopen tijd zijn er meerdere stapgroottestrategieën ontstaan om de SGD-prestaties te verbeteren. Een significante uitdaging die met deze stapgroottes gepaard gaat, houdt echter verband met hun waarschijnlijkheidsverdeling, aangeduid als ηt/ΣTt = 1ηt.

Er is waargenomen dat deze verdeling voorkomt dat extreem kleine waarden aan de laatste iteraties worden toegewezen. De veelgebruikte cosinusstapgrootte, hoewel effectief in de praktijk, stuit bijvoorbeeld op dit probleem door zeer lage waarschijnlijkheidsverdelingswaarden toe te wijzen aan de laatste iteraties.

Om deze uitdaging aan te gaan, publiceerde een onderzoeksteam onder leiding van M. Soheil Shamaee hun onderzoek in Grenzen van de informatica.

Het team introduceert een nieuwe logaritmische stapgrootte voor de SGD-benadering. Deze nieuwe stapgrootte is bijzonder effectief gebleken tijdens de laatste iteraties, waar de kans op selectie aanzienlijk groter is dan de conventionele cosinusstapgrootte.

Als gevolg hiervan overtreft de nieuwe stapgroottemethode de prestaties van de cosinusstapgroottemethode in deze kritische afsluitende iteraties, waarbij wordt geprofiteerd van de grotere kans dat deze als de geselecteerde oplossing wordt gekozen. De verkregen numerieke resultaten dienen als bewijs van de efficiëntie van de nieuw voorgestelde stapgrootte, met name op de FashionMinst-, CIFAR10- en CIFAR100-datasets.

Bovendien heeft de nieuwe logaritmische stapgrootte opmerkelijke verbeteringen in de testnauwkeurigheid laten zien, waardoor een toename van 0.9% werd bereikt voor de CIFAR100-dataset bij gebruik met een convolutioneel neuraal netwerk (CNN) -model.