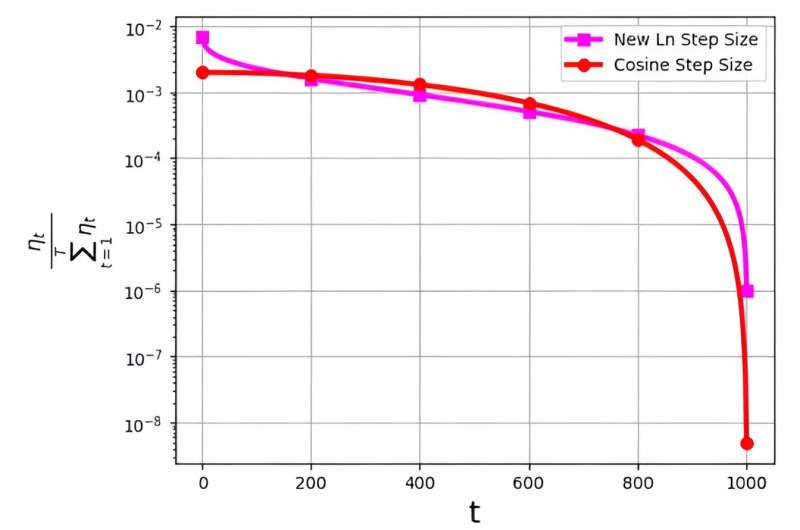

La dimensione del passo, spesso definita tasso di apprendimento, gioca un ruolo fondamentale nell'ottimizzazione dell'efficienza dell'algoritmo di discesa del gradiente stocastico (SGD). Negli ultimi tempi sono emerse strategie di dimensioni multiple per migliorare le prestazioni dell’SGD. Tuttavia, una sfida significativa associata a queste dimensioni dei passi è legata alla loro distribuzione di probabilità, indicata come ηt/ΣTt = 1ηt.

È stato osservato che questa distribuzione evita di assegnare valori eccessivamente piccoli alle iterazioni finali. Ad esempio, la dimensione del passo del coseno ampiamente utilizzata, sebbene efficace nella pratica, incontra questo problema assegnando valori di distribuzione di probabilità molto bassi alle ultime iterazioni.

Per affrontare questa sfida, un gruppo di ricerca guidato da M. Soheil Shamaee ha pubblicato la propria ricerca su Frontiere dell'informatica.

Il team introduce una nuova dimensione del passo logaritmico per l'approccio SGD. Questa nuova dimensione del passo si è rivelata particolarmente efficace durante le iterazioni finali, dove gode di una probabilità di selezione significativamente più elevata rispetto alla dimensione del passo del coseno convenzionale.

Di conseguenza, il nuovo metodo della dimensione del passo supera le prestazioni del metodo della dimensione del passo del coseno in queste iterazioni conclusive critiche, beneficiando della loro maggiore probabilità di essere scelto come soluzione selezionata. I risultati numerici ottenuti servono come testimonianza dell’efficienza della nuova dimensione del passo proposta, in particolare sui set di dati FashionMinst, CIFAR10 e CIFAR100.

Inoltre, la nuova dimensione del passo logaritmico ha mostrato notevoli miglioramenti nell’accuratezza del test, ottenendo un aumento dello 0.9% per il set di dati CIFAR100 se utilizzato con un modello di rete neurale convoluzionale (CNN).