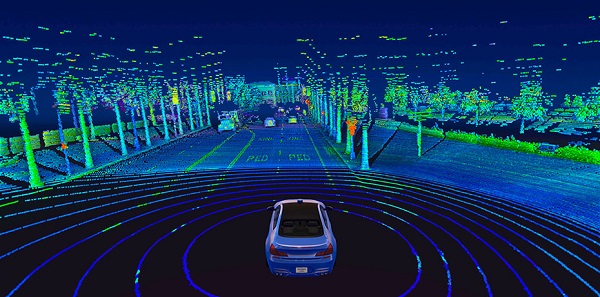

Wenn Sie in freier Wildbahn ein selbstfahrendes Auto sehen, bemerken Sie vielleicht einen riesigen sich drehenden Zylinder auf dem Dach. Das ist ein Lidar Sensor, und es funktioniert, indem es Infrarotlichtimpulse aussendet und die Zeit misst, die sie brauchen, um von Objekten abzuprallen. Dadurch entsteht eine Karte aus 3D-Punkten, die als Momentaufnahme der Umgebung des Autos dienen.

Ein Nachteil von Lidar ist, dass seine 3D-Daten immens und rechenintensiv sind. Ein typischer 64-Kanal-Sensor erzeugt beispielsweise mehr als 2 Millionen Punkte pro Sekunde. Aufgrund der zusätzlichen räumlichen Dimension erfordern die hochmodernen 3D-Modelle 14x mehr Berechnungen zur Inferenzzeit im Vergleich zu ihren 2D-Bildgegenstücken. Das bedeutet, dass Ingenieure, um effektiv navigieren zu können, die Daten in der Regel zunächst in 2D zusammenfassen müssen – der Nebeneffekt ist, dass dies zu erheblichen Informationsverlusten führt.

Ein Team vom MIT hat jedoch an einem selbstfahrenden System gearbeitet, das maschinelles Lernen verwendet, sodass keine benutzerdefinierte Handeinstellung erforderlich ist. Ihr neues End-to-End-Framework kann autonom navigieren und verwendet nur rohe 3D-Punktwolkendaten und GPS-Karten mit niedriger Auflösung, ähnlich denen, die heute auf Smartphones verfügbar sind.

End-to-End-Lernen aus LIDAR-Rohdaten ist ein rechenintensiver Prozess, da dem Computer riesige Mengen an reichhaltigen sensorischen Informationen zum Erlernen der Steuerung zur Verfügung gestellt werden. Aus diesem Grund musste das Team tatsächlich neue Deep-Learning-Komponenten entwickeln, die moderne GPU-Hardware effizienter nutzen, um das Fahrzeug in Echtzeit zu steuern.

„Wir haben unsere Lösung sowohl aus Algorithmus- als auch aus Systemsicht optimiert und eine kumulative Geschwindigkeit von etwa 9x im Vergleich zu bestehenden 3D-Lidar-Ansätzen erreicht“, sagt Ph.D. Student Zhijian Liu, der neben Alexander Amini der Co-Lead-Autor dieser Arbeit war.

In Tests zeigten die Forscher, dass ihr System reduzierte, wie oft ein menschlicher Fahrer die Kontrolle über die Maschine übernehmen musste und sogar schweren Sensorausfällen standhalten konnte.

Stellen Sie sich zum Beispiel vor, wie Sie durch einen Tunnel fahren und dann ins Sonnenlicht auftauchen – für den Bruchteil einer Sekunde werden Ihre Augen aufgrund der Blendung wahrscheinlich Probleme beim Sehen haben. Ein ähnliches Problem tritt bei den Kameras in selbstfahrenden Autos sowie bei den Lidar-Sensoren der Systeme bei schlechten Wetterbedingungen auf.

Um dies zu bewältigen, kann das System des MIT-Teams abschätzen, wie sicher es bezüglich einer bestimmten Vorhersage ist, und kann dieser Vorhersage daher mehr oder weniger Gewicht bei seinen Entscheidungen geben. (Im Falle eines Austritts aus einem Tunnel würde es im Wesentlichen jede Vorhersage ignorieren, der aufgrund ungenauer Sensordaten nicht vertraut werden sollte.)

Das Team nennt seinen Ansatz „hybrid Evidence Fusion“, weil er die verschiedenen Kontrollvorhersagen zusammenführt, um seine Bewegungsplanungsentscheidungen zu treffen.

„Durch die Verschmelzung der Steuerungsvorhersagen entsprechend der Unsicherheit des Modells kann sich das System an unerwartete Ereignisse anpassen“, sagt MIT-Professorin Daniela Rus, eine der leitenden Autoren der Studie.

Das System selbst ist in vielerlei Hinsicht eine Fusion aus drei früheren MIT-Projekten:

- MapLite, ein von Hand abgestimmtes Framework für das Fahren ohne hochauflösende 3D-Karten

- „Variationale End-to-End-Navigation“, ein maschinelles Lernsystem, das mit menschlichen Fahrdaten trainiert wird, um die Navigation von Grund auf neu zu erlernen

- SPVNAS, ein effizientes 3D Deep-Learning-Lösung, die die neuronale Architektur und Inferenzbibliothek optimiert

„Wir haben die Vorteile eines kartenlosen Fahransatzes genutzt und ihn mit durchgängigem maschinellem Lernen kombiniert, sodass wir keine erfahrenen Programmierer benötigen, die das System von Hand abstimmen“, sagt Amini.

Als nächsten Schritt plant das Team, sein System weiterhin auf die zunehmende Komplexität in der realen Welt zu skalieren, einschließlich widriger Wetterbedingungen und dynamischer Interaktion mit anderen Fahrzeugen.