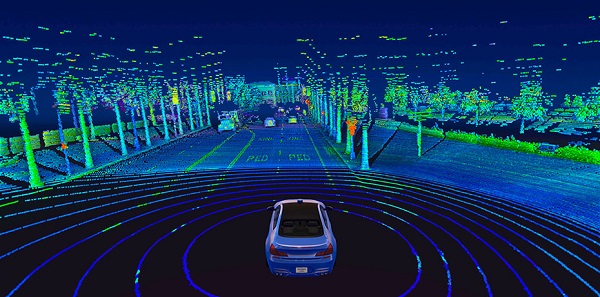

Als je een zelfrijdende auto in het wild ziet, zie je misschien een gigantische draaiende cilinder op het dak. Dat is een lidar sensor, en het werkt door pulsen van infrarood licht uit te zenden en de tijd te meten die nodig is om van objecten te weerkaatsen. Dit creëert een kaart van 3D-punten die dienen als een momentopname van de omgeving van de auto.

Een nadeel van lidar is dat de 3D-gegevens enorm en rekenintensief zijn. Een typische 64-kanaals sensor produceert bijvoorbeeld meer dan 2 miljoen punten per seconde. Vanwege de extra ruimtelijke dimensie vereisen de state-of-the-art 3D-modellen 14x meer rekenkracht op de inferentietijd in vergelijking met hun 2D-beeld-tegenhangers. Dit betekent dat, om effectief te kunnen navigeren, ingenieurs de gegevens doorgaans eerst in 2D moeten samenvouwen - het neveneffect hiervan is dat het een aanzienlijk informatieverlies met zich meebrengt.

Maar een team van MIT heeft gewerkt aan een zelfrijdend systeem dat gebruikmaakt van machine learning, zodat aangepaste handmatige afstemming niet nodig is. Hun nieuwe end-to-end-framework kan autonoom navigeren met alleen onbewerkte 3D-puntenwolkgegevens en GPS-kaarten met een lage resolutie, vergelijkbaar met de kaarten die tegenwoordig op smartphones beschikbaar zijn.

End-to-end leren van onbewerkte lidar-gegevens is een rekenintensief proces, omdat het inhoudt dat de computer enorme hoeveelheden rijke sensorische informatie krijgt om te leren sturen. Daarom moest het team daadwerkelijk nieuwe deep learning-componenten ontwerpen die moderne GPU-hardware efficiënter gebruikten om het voertuig in realtime te besturen.

"We hebben onze oplossing zowel vanuit algoritme- als systeemperspectief geoptimaliseerd, waarbij we een cumulatieve snelheid van ongeveer 9x hebben bereikt in vergelijking met bestaande 3D-lidar-benaderingen", zegt Ph.D. student Zhijian Liu, die samen met Alexander Amini de co-hoofdauteur van dit artikel was.

In tests toonden de onderzoekers aan dat hun systeem verminderde hoe vaak een menselijke bestuurder de controle over de machine moest overnemen, en zelfs bestand was tegen ernstige sensorstoringen.

Stel je bijvoorbeeld voor dat je door een tunnel rijdt en dan het zonlicht induikt - gedurende een fractie van een seconde zullen je ogen waarschijnlijk problemen hebben met zien vanwege de schittering. Een soortgelijk probleem doet zich voor bij de camera's in zelfrijdende auto's, maar ook bij de lidar-sensoren van de systemen bij slechte weersomstandigheden.

Om dit aan te pakken, kan het systeem van het MIT-team inschatten hoe zeker het is over een bepaalde voorspelling, en kan daarom meer of minder gewicht geven aan die voorspelling bij het nemen van beslissingen. (In het geval van uit een tunnel komen, zou het in wezen elke voorspelling negeren die niet zou moeten worden vertrouwd vanwege onnauwkeurige sensorgegevens.)

Het team noemt hun aanpak "hybride bewijskrachtfusie", omdat het de verschillende controlevoorspellingen samensmelt om tot zijn bewegingsplanningskeuzes te komen.

"Door de controlevoorspellingen te fuseren op basis van de onzekerheid van het model, kan het systeem zich aanpassen aan onverwachte gebeurtenissen", zegt MIT-professor Daniela Rus, een van de senior auteurs van het artikel.

In veel opzichten is het systeem zelf een samensmelting van drie eerdere MIT-projecten:

- MapLite, een met de hand afgesteld raamwerk voor autorijden zonder high-definition 3D-kaarten

- "variationele end-to-end navigatie", een machine learning-systeem dat is getraind met behulp van menselijke rijgegevens om vanaf het begin te leren navigeren

- SPVNAS, een efficiënte 3D deep learning-oplossing die de neurale architectuur en inferentiebibliotheek optimaliseert

"We hebben gebruik gemaakt van de voordelen van een kaartloze rijaanpak en deze gecombineerd met end-to-end machine learning, zodat we geen deskundige programmeurs nodig hebben om het systeem met de hand af te stemmen", zegt Amini.

Als volgende stap is het team van plan om hun systeem verder op te schalen naar toenemende complexiteit in de echte wereld, inclusief ongunstige weersomstandigheden en dynamische interactie met andere voertuigen.