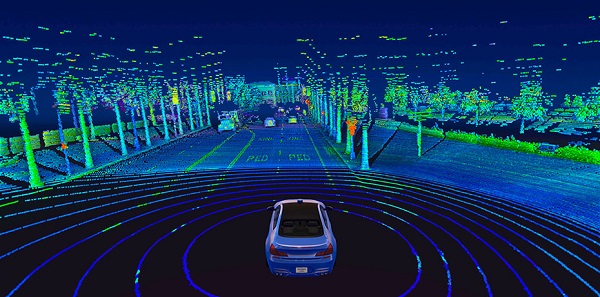

야생에서 자율 주행 자동차를 본다면 지붕 위에 거대한 회전 실린더가있는 것을 볼 수 있습니다. 그것은 라이더입니다 감지기, 적외선 펄스를 내보내고 물체에서 반사되는 데 걸리는 시간을 측정하여 작동합니다. 이렇게하면 자동차 주변의 스냅 샷 역할을하는 3D 포인트 맵이 생성됩니다.

라이더의 한 가지 단점은 3D 데이터가 방대하고 계산 집약적이라는 것입니다. 예를 들어 일반적인 64 채널 센서는 초당 2 백만 개 이상의 포인트를 생성합니다. 추가적인 공간 차원으로 인해 최첨단 3D 모델은 14D 이미지에 비해 추론 시간에 2 배 더 많은 계산이 필요합니다. 즉, 효과적으로 탐색하기 위해 엔지니어는 먼저 데이터를 2D로 축소해야합니다. 이로 인한 부작용은 상당한 정보 손실을 초래한다는 것입니다.

그러나 MIT의 한 팀은 맞춤형 수동 조정이 필요하지 않도록 기계 학습을 사용하는 자율 주행 시스템을 개발하고 있습니다. 새로운 엔드-투-엔드 프레임 워크는 오늘날 스마트 폰에서 사용 가능한 것과 유사한 원시 3D 포인트 클라우드 데이터와 저해상도 GPS지도 만 사용하여 자율적으로 탐색 할 수 있습니다.

원시 라이더 데이터에서 엔드-투-엔드 학습은 컴퓨터가 조종하는 방법을 배우기 위해 엄청난 양의 풍부한 감각 정보를 제공하기 때문에 계산 집약적 인 프로세스입니다. 이 때문에 팀은 차량을 실시간으로 제어하기 위해 최신 GPU 하드웨어를보다 효율적으로 활용하는 새로운 딥 러닝 구성 요소를 실제로 설계해야했습니다.

“우리는 알고리즘 및 시스템 관점에서 솔루션을 최적화하여 기존 9D 라이더 접근 방식에 비해 약 3 배의 누적 속도 향상을 달성했습니다.”라고 Ph.D는 말합니다. 알렉산더 아 미니와 함께이 논문의 공동 주 저자였던 학생 Zhijian Liu.

테스트에서 연구원들은 그들의 시스템이 인간 운전자가 기계를 제어해야하는 빈도를 줄이고 심각한 센서 고장을 견딜 수 있음을 보여주었습니다.

예를 들어, 터널을 통해 운전하다가 햇빛으로 떠오르는 모습을 상상해보십시오. 잠시 동안 눈부심 때문에 눈이 잘 보이지 않을 수 있습니다. 자율 주행 차의 카메라와 기상 조건이 좋지 않을 때 시스템의 라이더 센서에서도 비슷한 문제가 발생합니다.

이를 처리하기 위해 MIT 팀의 시스템은 주어진 예측에 대해 얼마나 확실한지 추정 할 수 있으므로 결정을 내릴 때 해당 예측에 어느 정도 가중치를 줄 수 있습니다. (터널에서 나오는 경우 부정확 한 센서 데이터로 인해 신뢰할 수없는 예측을 본질적으로 무시합니다.)

팀은 그들의 접근 방식을 "하이브리드 증거 융합"이라고 부릅니다. 이는 다양한 제어 예측을 융합하여 모션 계획 선택에 도달하기 때문입니다.

이 논문의 수석 저자 중 한 명인 MIT 교수 인 Daniela Rus는“모델의 불확실성에 따라 제어 예측을 융합함으로써 시스템이 예상치 못한 사건에 적응할 수 있습니다.

여러 측면에서 시스템 자체는 세 가지 이전 MIT 프로젝트의 융합입니다.

- 고화질 3D지도가없는 운전을위한 수동 조정 프레임 워크 MapLite

- 처음부터 탐색하는 방법을 학습하기 위해 사람의 운전 데이터를 사용하여 훈련 된 기계 학습 시스템 인 "가변적 종단 간 탐색"

- SPVNAS, 효율적인 3D 신경 아키텍처 및 추론 라이브러리를 최적화하는 딥 러닝 솔루션

"우리는지도없는 운전 접근 방식의 이점을 취하고이를 엔드 투 엔드 머신 러닝과 결합하여 시스템을 수동으로 조정하기 위해 전문 프로그래머가 필요하지 않습니다."라고 Amini는 말합니다.

다음 단계로 팀은 악천후 조건 및 다른 차량과의 동적 상호 작용을 포함하여 현실 세계에서 점점 더 복잡해 지도록 시스템을 계속 확장 할 계획입니다.