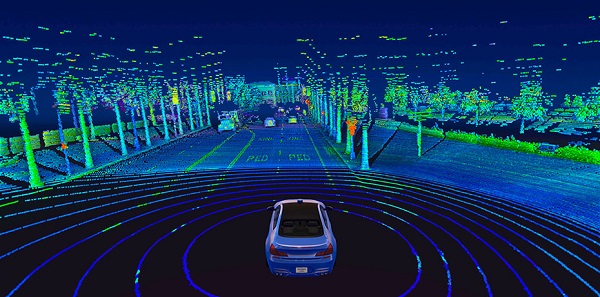

野外で自動運転車を見かけたら、屋根の上に巨大な回転するシリンダーがあることに気付くかもしれません。 それはライダーです センサー、赤外線のパルスを送信し、物体から跳ね返るのにかかる時間を測定することで機能します。 これにより、車の周囲のスナップショットとして機能する 3D ポイントのマップが作成されます。

LIDAR の欠点の 3 つは、その 64D データが膨大で計算負荷が高いことです。 たとえば、典型的な 2 チャネル センサーは、毎秒 3 万点以上のデータを生成します。 追加の空間次元により、最先端の 14D モデルは、2D 画像の対応物と比較して、推論時に 2 倍多くの計算を必要とします。 これは、効率的にナビゲートするために、エンジニアは通常、最初にデータを XNUMXD に折りたたむ必要があることを意味します。これの副作用として、重大な情報損失が発生します。

しかし、MIT のチームは、機械学習を使用する自動運転システムに取り組んでおり、カスタムの手動チューニングが必要ありません。 彼らの新しいエンド ツー エンドのフレームワークは、生の 3D 点群データと低解像度の GPS マップのみを使用して自律的にナビゲートできます。これは、今日のスマートフォンで利用できるものと同様です。

生の LIDAR データからのエンド ツー エンドの学習は、コンピューターに操縦方法を学習するための豊富な感覚情報を大量に与える必要があるため、計算負荷の高いプロセスです。 このため、チームは、車両をリアルタイムで制御するために、最新の GPU ハードウェアをより効率的に活用する新しい深層学習コンポーネントを実際に設計する必要がありました。

「アルゴリズムとシステムの両方の観点からソリューションを最適化し、既存の 9D LiDAR アプローチと比較して約 3 倍の累積的なスピードアップを達成しました」と博士は述べています。 学生の Zhijian Liu は、Alexander Amini と並んでこの論文の共同主執筆者でした。

テストで、研究者は、彼らのシステムが人間のドライバーが機械から制御を引き継ぐ頻度を減らし、深刻なセンサーの故障にさえ耐えることができることを示しました。

たとえば、トンネルを通り抜けて太陽の光を浴びている自分を想像してみてください。ほんの一瞬、まぶしさのせいで目が見えなくなる可能性があります。 自動運転車のカメラや、悪天候時のシステムのライダー センサーでも同様の問題が発生します。

これに対処するために、MIT チームのシステムは、特定の予測についてどの程度確実であるかを推定できるため、決定を行う際にその予測に多かれ少なかれ重みを与えることができます。 (トンネルから出現する場合、不正確なセンサー データのために信頼すべきでない予測は基本的に無視されます。)

チームは、このアプローチを「ハイブリッド証拠融合」と呼んでいます。これは、さまざまな制御予測を融合してモーション プランニングの選択肢に到達するためです。

「モデルの不確実性に従って制御予測を融合することにより、システムは予期しないイベントに適応することができます」と、論文の上級著者の XNUMX 人である MIT のダニエラ・ラス教授は述べています。

多くの点で、システム自体は XNUMX つの以前の MIT プロジェクトの融合です。

- MapLite、高解像度 3D マップなしで運転するための手動調整フレームワーク

- 人間の運転データを使用してゼロからナビゲートする方法を学習する機械学習システム「バリエーション エンド ツー エンド ナビゲーション」

- SPVNAS、効率的な 3D ニューラル アーキテクチャと推論ライブラリを最適化する深層学習ソリューション

「マップレス運転アプローチの利点を活用し、それをエンド ツー エンドの機械学習と組み合わせて、熟練したプログラマーが手動でシステムを調整する必要がないようにしました」と Amini 氏は言います。

次のステップとして、チームは、悪天候や他の車両との動的な相互作用など、現実世界の複雑さの増大に合わせてシステムを拡張し続けることを計画しています。