Jingbo Meng, außerordentlicher Professor für Kommunikation bei ComArtSci, wollte herausfinden, wie effektiv Chatbots mit künstlicher Intelligenz (KI) bei der Übermittlung unterstützender Nachrichten sein können. Also startete sie die Recherche und nutzte eine Chatbot-Entwicklungsplattform, um sie zu testen.

„Chatbots werden im Kundenservice durch text- oder sprachbasierte Kommunikation weit verbreitet eingesetzt“, sagte sie. „Es ist eine natürliche Erweiterung, darüber nachzudenken, wie KI-Chatbots dazu beitragen können, Empathie zu vermitteln, nachdem man sich die Geschichten und Sorgen einer Person angehört hat.“

Ich unterhalte mich darüber

Anfang 2019 begann Meng, die Wirksamkeit empathischer Chatbots zu bewerten, indem er sie mit menschlichem Chat verglich. Sie hatte das Wachstum digitaler Gesundheits- und Wellness-Apps verfolgt und das phänomenale Wachstum derjenigen im Zusammenhang mit der psychischen Gesundheit beobachtet. Ihre frühere Zusammenarbeit mit MSU-Ingenieurkollegen konzentrierte sich auf ein tragbares mobiles System zur Erkennung, Verfolgung und Abfrage von Verhaltensmerkmalen von Stress und Depression bei Benutzern. Die Zusammenarbeit inspirierte sie dazu, Chatbots zu verwenden, die Gespräche mit Benutzern initiieren, wenn die Verhaltensmarker identifiziert werden.

„Wir hatten das Gefühl, dass einige Chatbot-Kommunikationen funktionieren könnten, andere vielleicht nicht“, sagte Meng. „Ich wollte mehr Forschung betreiben, um zu verstehen, warum das so ist, damit wir wirksamere Botschaften entwickeln können, die wir in Apps für psychische Gesundheit nutzen können.“

Meng rekrutierte 278 MSU-Studenten für ihre Studie und bat sie, die wichtigsten Stressfaktoren zu identifizieren, denen sie im vergangenen Monat ausgesetzt waren. Anschließend wurden die Teilnehmer über den Facebook Messenger mit einem einfühlsamen Chatpartner verbunden. Einer Gruppe wurde gesagt, dass sie mit einem Chatbot sprechen würde, einer anderen wurde klar, dass sie mit einem Menschen sprechen würden. Die Falte? Meng hat es so eingerichtet, dass nur Chatbots Anfragen und Nachrichten übermitteln. So konnte sie messen, ob Teilnehmer anders reagierten, wenn sie dachten, ihr Chatpartner sei ein Mensch.

Meng variierte auch den Grad der gegenseitigen Selbstoffenbarung, den die Teilnehmer während ihrer 20-minütigen Sitzungen erleben würden. Einige Chatbots teilten ihre eigenen Erfahrungen, um Empathie zu wecken. Andere Chatbots legten lediglich ihre eigenen persönlichen Probleme dar, auf Kosten der fehlenden Validierung der Teilnehmer.“

Mit Ausnahme der unterschiedlichen wechselseitigen Selbstauskunftsszenarien wurden Inhalt und Gesprächsablauf für Chatbots und die vermeintlichen menschlichen Chatpartner exakt gleich geschrieben. Chatbots forderten die Teilnehmer auf, Stressfaktoren zu identifizieren. Sie fragten, wie sich die Teilnehmer fühlten. Sie untersuchten, warum die Teilnehmer dachten, dass Stress sie auf bestimmte Weise fühlen ließe. Dann teilten Chatbots ihre eigenen Erfahrungen.

„Sie wurden so programmiert, dass sie den Teilnehmern helfen, Stresssituationen zu meistern“, sagte sie. „Unser Ziel war es herauszufinden, wie effektiv die Nachrichtenübermittlung sein kann.“

Aufpassen

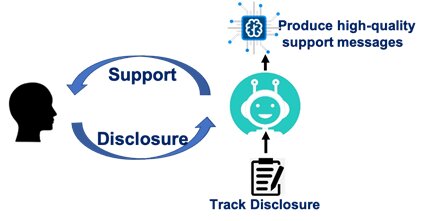

Meng fand heraus, dass ein Teilnehmer unabhängig davon, ob er mit einem Chatbot oder einem Menschen spricht, das Gefühl haben muss, dass der Partner ihn unterstützt oder fürsorglich ist. Wenn diese Bedingung erfüllt ist, führt das Gespräch zu einem erfolgreichen Stressabbau.

Ihre Studie ergab auch, dass die Teilnehmer unabhängig von der Nachricht das Gefühl hatten, Menschen seien fürsorglicher und unterstützender als ein Chatbot.

Ihre Szenarien zur gegenseitigen Selbstoffenlegung erzählten eine andere Geschichte. Menschliche Partner, die sich selbst offenbarten – unabhängig davon, ob sie die Absicht hatten, empathisch zu sein oder einfach nur auf ihre eigenen Probleme einzugehen – trugen zur Stressreduzierung bei. Aber Chatbots, die sich offenbarten, ohne emotionale Unterstützung anzubieten, trugen wenig dazu bei, den Stress eines Teilnehmers zu reduzieren – noch weniger als Chatbots, die überhaupt nichts sagten.

„Menschen sind einfach verständlicher“, sagte Meng. „Wenn wir mit einem anderen Menschen sprechen, können wir eine natürlichere Beziehung aufbauen, auch wenn er unsere Gefühle nicht bestätigt. Chatbots müssen jedoch expliziter sein und qualitativ hochwertigere Nachrichten senden. Andernfalls kann die Selbstauskunft nervig und abstoßend sein.“

Die Quelle wahrnehmen

Meng führte und analysierte Forschungsarbeiten mit Yue (Nancy) Dai, einer Absolventin des Kommunikationsdoktorandenprogramms der MSU im Jahr 2018 und Professorin an der City University of Hong Kong. Ihre Ergebnisse wurden in der veröffentlicht Zeitschrift für computervermittelte Kommunikation.

Meng sagte, die Studie unterstreiche, dass Chatbots, die in Apps für psychische Gesundheit eingesetzt werden, am besten funktionieren, wenn sie als wirklich fürsorgliche Quelle wahrgenommen werden. Sie plant, die Studie mit weiteren Untersuchungen fortzusetzen, die untersuchen, wie Nachrichten so gestaltet werden können, dass der Fürsorgefaktor gestärkt wird.

Sie sagte, Apps für die psychische Gesundheit würden nicht verschwinden, sondern ihre Nutzung und Verfügbarkeit zunehmen. Während die Mehrheit der Menschen Zugang zu einem Mobiltelefon hat, haben viele keinen direkten Zugang zu einem Therapeuten oder einer Krankenversicherung. Apps, sagte sie, können Einzelpersonen dabei helfen, bestimmte Situationen zu bewältigen, und Benchmarks für zusätzliche unterstützende Pflege liefern.

„Diese Apps und Chatbots werden auf keinen Fall einen Menschen ersetzen“, sagte sie. „Wir glauben, dass das Hybridmodell von AI Chatbots und ein menschlicher Therapeut werden sehr vielversprechend sein.“