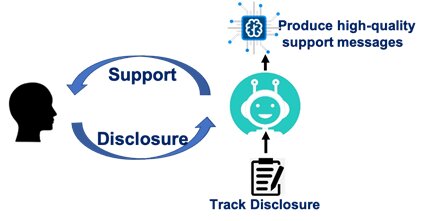

Il professore associato di comunicazione di ComArtSci Jingbo Meng voleva vedere quanto potessero essere efficaci i chatbot di intelligenza artificiale (AI) nel fornire messaggi di supporto. Quindi ha impostato la ricerca e ha utilizzato una piattaforma di sviluppo di chatbot per testarla.

"I chatbot sono stati ampiamente applicati nel servizio clienti attraverso comunicazioni testuali o vocali", ha affermato. "È un'estensione naturale pensare a come i chatbot di intelligenza artificiale possono svolgere un ruolo nel fornire empatia dopo aver ascoltato le storie e le preoccupazioni di qualcuno".

Chiacchierando

All'inizio del 2019, Meng ha iniziato a valutare l'efficacia dei chatbot empatici confrontandoli con la chat umana. Aveva seguito la crescita delle app digitali per la salute e il benessere e aveva visto la crescita fenomenale di quelle relative alla salute mentale. La sua precedente collaborazione con i colleghi ingegneri della MSU si è concentrata su un sistema mobile indossabile per rilevare, tracciare e interrogare gli utenti sui marcatori comportamentali di stress e depressione. La collaborazione l'ha ispirata a utilizzare chatbot che avviano conversazioni con gli utenti quando vengono identificati i marcatori comportamentali.

"Abbiamo intuito che alcune comunicazioni tramite chatbot potrebbero funzionare, altre no", ha detto Meng. "Volevo fare più ricerche per capire perché, in modo da poter sviluppare messaggi più efficaci da utilizzare all'interno delle app per la salute mentale".

Meng ha reclutato 278 studenti universitari MSU per il suo studio e ha chiesto loro di identificare i principali fattori di stress che avevano sperimentato nell'ultimo mese. I partecipanti sono stati quindi collegati tramite Facebook Messenger con un partner di chat empatico. A un gruppo è stato detto che avrebbero parlato con un chatbot, un altro ha capito che avrebbero parlato con un umano. La ruga? Meng l'ha impostato in modo che solo i chatbot consegnassero query e messaggi, permettendole di misurare se i partecipanti reagivano in modo diverso quando pensavano che il loro partner di chat fosse umano.

Meng ha anche variato il livello di rivelazione reciproca che i partecipanti avrebbero sperimentato durante le loro sessioni di 20 minuti. Alcuni chatbot hanno condiviso le proprie esperienze per evocare empatia. Altri chatbot hanno semplicemente esposto i propri problemi personali a spese di non convalidare i partecipanti.

Con l'eccezione dei diversi scenari di auto-divulgazione reciproca, il contenuto e il flusso delle conversazioni sono stati scritti esattamente allo stesso modo per i chatbot e per i partner di chat umani percepiti. I chatbot hanno chiesto ai partecipanti di identificare i fattori di stress. Hanno chiesto come si sentivano i partecipanti. Hanno sondato il motivo per cui i partecipanti pensavano che i fattori di stress li facessero sentire in determinati modi. Quindi i chatbot hanno condiviso le proprie esperienze.

"Sono stati programmati per convalidare e aiutare i partecipanti a superare situazioni stressanti", ha detto. "Il nostro obiettivo era vedere quanto potesse essere efficace la messaggistica".

Prendersi cura

Meng ha scoperto che, parlando con un chatbot o con un essere umano, un partecipante doveva sentire che il partner era solidale o premuroso. Se questa condizione è soddisfatta, la conversazione ha successo nel ridurre lo stress.

Il suo studio ha anche rivelato che, indipendentemente dal messaggio, i partecipanti sentivano che gli umani erano più premurosi e di supporto di un chatbot.

I suoi scenari sulla reciproca rivelazione di sé raccontavano un'altra storia. I partner umani che si sono rivelati, indipendentemente dal fatto che il loro intento fosse quello di essere empatici o semplicemente di elaborare i propri problemi, hanno contribuito alla riduzione dello stress. Ma i chatbot che si sono rivelati senza offrire supporto emotivo hanno fatto poco per ridurre lo stress di un partecipante, anche meno dei chatbot che non dicevano nulla.

"Gli esseri umani sono semplicemente più facilmente riconoscibili", ha detto Meng. “Quando parliamo con un altro umano, anche quando non convalida le nostre emozioni, possiamo relazionarci in modo più naturale. I chatbot, tuttavia, devono essere più espliciti e inviare messaggi di qualità superiore. Altrimenti, l'auto-rivelazione può essere fastidiosa e scoraggiante".

Percepire la fonte

Meng ha condotto e analizzato la ricerca con Yue (Nancy) Dai, un'alunna del 2018 del programma di dottorato in Comunicazione della MSU e professore presso la City University di Hong Kong. I loro risultati sono stati pubblicati nel Rivista di comunicazione mediata dal computer.

Meng ha affermato che lo studio sottolinea che i chatbot utilizzati nelle app per la salute mentale funzionano meglio se percepiti come una fonte veramente premurosa. Ha in programma di dare seguito allo studio con ulteriori ricerche che esaminino come la messaggistica possa essere progettata per aumentare il fattore di cura.

Le app per la salute mentale, ha affermato, non stanno scomparendo e, in effetti, stanno aumentando in uso e disponibilità. Mentre la maggior parte delle persone ha accesso a un telefono cellulare, molti non hanno accesso immediato a un terapista o a un'assicurazione sanitaria. Le app, ha affermato, possono aiutare le persone a gestire situazioni particolari e possono fornire punti di riferimento per ulteriori cure di supporto.

"In nessun caso queste app e chatbot sostituiranno un essere umano", ha affermato. “Crediamo che il modello ibrido di AI chatbot e un terapista umano saranno molto promettenti”.