O professor associado de comunicação da ComArtSci, Jingbo Meng, queria ver como os chatbots de inteligência artificial (IA) poderiam ser eficazes na entrega de mensagens de apoio. Então, ela configurou a pesquisa e usou uma plataforma de desenvolvimento de chatbot para testá-la.

“Os chatbots têm sido amplamente aplicados no atendimento ao cliente por meio de comunicação baseada em texto ou voz”, disse ela. “É uma extensão natural pensar sobre como os chatbots de IA podem desempenhar um papel no fornecimento de empatia depois de ouvir as histórias e preocupações de alguém.”

Conversando

No início de 2019, Meng começou a avaliar a eficácia dos chatbots empáticos comparando-os com o chat humano. Ela vinha acompanhando o crescimento dos aplicativos digitais de saúde e bem-estar e viu o crescimento fenomenal daqueles relacionados à saúde mental. Sua colaboração anterior com colegas de engenharia da MSU se concentrou em um sistema móvel vestível para detectar, rastrear e consultar os usuários sobre marcadores comportamentais de estresse e depressão. A colaboração a inspirou a usar chatbots que iniciam conversas com usuários quando os marcadores comportamentais são identificados.

“Sentimos que algumas comunicações do chatbot podem funcionar, outras não”, disse Meng. “Eu queria fazer mais pesquisas para entender por que, para que possamos desenvolver mensagens mais eficazes para usar em aplicativos de saúde mental.”

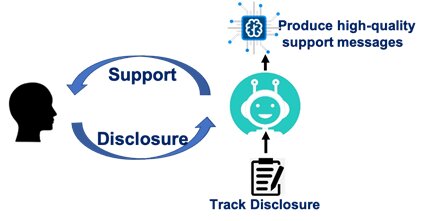

Meng recrutou 278 alunos de graduação da MSU para seu estudo e pediu-lhes que identificassem os principais estressores que experimentaram no mês anterior. Os participantes foram então conectados através do Facebook Messenger com um parceiro de bate-papo empático. Um grupo foi informado que conversaria com um chatbot, outro entendeu que conversaria com um humano. A ruga? Meng configurou para que apenas chatbots entregassem consultas e mensagens, permitindo-lhe medir se os participantes reagiam de forma diferente quando pensavam que seu parceiro de bate-papo era humano.

Meng também variou o nível de auto-revelação recíproca que os participantes experimentariam durante suas sessões de 20 minutos. Alguns chatbots compartilharam suas próprias experiências como forma de evocar empatia. Outros chatbots simplesmente expuseram seus próprios problemas pessoais às custas de não validar os participantes ”.

Com exceção dos diferentes cenários de autorrevelação recíproca, o conteúdo e o fluxo das conversas foram programados exatamente da mesma forma para chatbots e para os parceiros de bate-papo humanos percebidos. O chatbots pediu aos participantes que identificassem os estressores. Eles perguntaram como os participantes se sentiam. Eles investigaram por que os participantes achavam que os estressores os faziam se sentir de certas maneiras. Então, os chatbots compartilharam suas próprias experiências.

“Eles foram programados para validar e ajudar os participantes a superar situações estressantes”, disse ela. “Nosso objetivo era ver o quão eficaz a mensagem poderia ser.”

Cuidando

Meng descobriu que, seja falando com um chatbot ou com um humano, o participante deve sentir que o parceiro o apóia ou se importa. Se essa condição for atendida, a conversa terá sucesso em reduzir o estresse.

Seu estudo também revelou que, independentemente da mensagem, os participantes sentiram que os humanos eram mais atenciosos e apoiadores do que um chatbot.

Seus cenários de autorrevelação recíproca contavam outra história. Parceiros humanos que se revelaram - independentemente de sua intenção ser empática ou apenas elaborar seus próprios problemas - contribuíram para a redução do estresse. Mas os chatbots que se revelaram sem oferecer apoio emocional fizeram pouco para reduzir o estresse de um participante - menos ainda do que os chatbots que não disseram nada.

“Os humanos são simplesmente mais identificáveis”, disse Meng. “Quando falamos com outro humano, mesmo quando eles não validam nossas emoções, podemos nos relacionar com mais naturalidade. No entanto, os chatbots precisam ser mais explícitos e enviar mensagens de alta qualidade. Caso contrário, a auto-revelação pode ser irritante e desagradável. ”

Percebendo a fonte

Meng conduziu e analisou pesquisas com Yue (Nancy) Dai, ex-aluno do programa de doutorado em Comunicação da MSU em 2018 e professor da City University of Hong Kong. Suas descobertas foram publicadas no Veses es v es es v es

Meng disse que o estudo ressalta que os chatbots usados em aplicativos de saúde mental funcionam melhor quando percebidos como uma fonte verdadeiramente atenciosa. Ela planeja acompanhar o estudo com pesquisas adicionais que examinem como as mensagens podem ser projetadas para aumentar o fator de cuidado.

Os aplicativos de saúde mental, disse ela, não estão indo embora e, de fato, estão aumentando em uso e disponibilidade. Embora a maioria das pessoas tenha acesso a um telefone celular, muitas não têm acesso imediato a um terapeuta ou seguro de saúde. Os aplicativos, disse ela, podem ajudar os indivíduos a gerenciar situações particulares e fornecer referências para cuidados de suporte adicionais.

“De forma alguma esses apps e chatbots substituirão um ser humano”, disse ela. “Acreditamos que o modelo híbrido de AI chatbots e um terapeuta humano serão muito promissores. ”