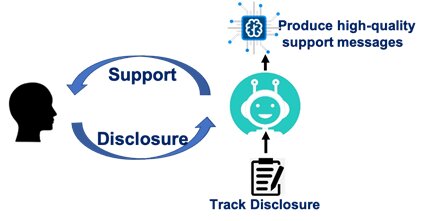

Le professeur agrégé de communication ComArtSci, Jingbo Meng, voulait voir à quel point les chatbots d'intelligence artificielle (IA) pouvaient être efficaces pour transmettre des messages de soutien. Elle a donc mis en place la recherche et a utilisé une plate-forme de développement de chatbot pour la tester.

« Les chatbots ont été largement appliqués au service client via la communication textuelle ou vocale », a-t-elle déclaré. « C'est une extension naturelle de réfléchir à la façon dont les chatbots IA peuvent jouer un rôle en fournissant de l'empathie après avoir écouté les histoires et les préoccupations de quelqu'un. »

Discuter

Début 2019, Meng a commencé à évaluer l'efficacité des chatbots empathiques en les comparant au chat humain. Elle avait suivi la croissance des applications numériques de santé et de bien-être et avait constaté la croissance phénoménale de celles liées à la santé mentale. Sa collaboration précédente avec des collègues ingénieurs de MSU portait sur un système mobile portable pour détecter, suivre et interroger les utilisateurs sur les marqueurs comportementaux du stress et de la dépression. La collaboration l'a inspirée à utiliser des chatbots qui initient des conversations avec les utilisateurs lorsque les marqueurs comportementaux sont identifiés.

"Nous avons senti que certaines communications de chatbot pourraient fonctionner, d'autres non", a déclaré Meng. "Je voulais faire plus de recherches pour comprendre pourquoi afin que nous puissions développer des messages plus efficaces à utiliser dans les applications de santé mentale."

Meng a recruté 278 étudiants de premier cycle de la MSU pour son étude et leur a demandé d'identifier les principaux facteurs de stress qu'ils avaient subis au cours du mois dernier. Les participants ont ensuite été connectés via Facebook Messenger avec un partenaire de discussion empathique. Un groupe a été informé qu'il parlerait avec un chatbot, un autre a compris qu'il parlerait avec un humain. La ride ? Meng l'a configuré pour que seuls les chatbots transmettent des requêtes et des messages, ce qui lui permet de mesurer si les participants ont réagi différemment lorsqu'ils pensaient que leur partenaire de discussion était humain.

Meng a également fait varier le niveau d'auto-divulgation réciproque que les participants ressentiraient au cours de leurs sessions de 20 minutes. Certains chatbots ont partagé leurs propres expériences comme moyen d'évoquer l'empathie. D'autres chatbots ont simplement exposé leurs problèmes personnels au détriment de la non-validation des participants.

À l'exception des différents scénarios d'auto-divulgation réciproque, le contenu et le flux des conversations ont été scénarisés exactement de la même manière pour les chatbots et pour les partenaires de discussion humains perçus. Les chatbots ont demandé aux participants d'identifier les facteurs de stress. Ils ont demandé comment les participants se sentaient. Ils ont cherché à savoir pourquoi les participants pensaient que les facteurs de stress leur faisaient ressentir certaines choses. Ensuite, les chatbots ont partagé leurs propres expériences.

« Ils ont été programmés pour valider et aider les participants à traverser des situations stressantes », a-t-elle déclaré. « Notre objectif était de voir à quel point le message pouvait être efficace. »

Prendre soin

Meng a découvert que, qu'il s'adresse à un chatbot ou à un humain, un participant devait sentir que le partenaire le soutient ou s'occupe d'eux. Si cette condition est remplie, la conversation réussit à réduire le stress.

Son étude a également révélé que quel que soit le message, les participants pensaient que les humains étaient plus attentionnés et solidaires qu'un chatbot.

Ses scénarios sur l'auto-divulgation réciproque racontaient une autre histoire. Les partenaires humains qui se sont révélés, que leur intention soit d'être empathique ou simplement d'élaborer sur leurs propres problèmes, ont contribué à la réduction du stress. Mais les chatbots qui se sont révélés sans offrir de soutien émotionnel n'ont pas fait grand-chose pour réduire le stress d'un participant, encore moins que les chatbots qui n'ont rien dit du tout.

"Les humains sont tout simplement plus faciles à comprendre", a déclaré Meng. « Lorsque nous parlons avec un autre humain, même lorsqu'il ne valide pas nos émotions, nous pouvons nous connecter plus naturellement. Les chatbots, cependant, doivent être plus explicites et envoyer des messages de meilleure qualité. Sinon, la divulgation de soi peut être ennuyeuse et rebutante. »

Percevoir la source

Meng a mené et analysé des recherches avec Yue (Nancy) Dai, une ancienne élève de 2018 du programme de doctorat en communication de MSU et professeur à la City University of Hong Kong. Leurs conclusions ont été publiées dans le Journal of Computer-Mediated Communication.

Meng a déclaré que l'étude souligne que les chatbots utilisés dans les applications de santé mentale fonctionnent mieux lorsqu'ils sont perçus comme une source vraiment attentionnée. Elle prévoit de poursuivre l'étude avec des recherches supplémentaires qui examinent comment les messages peuvent être conçus pour augmenter le facteur de bienveillance.

Les applications de santé mentale, a-t-elle déclaré, ne disparaissent pas et, en fait, leur utilisation et leur disponibilité augmentent. Alors que la majorité des gens ont accès à un téléphone mobile, beaucoup n'ont pas facilement accès à un thérapeute ou à une assurance maladie. Les applications, a-t-elle déclaré, peuvent aider les individus à gérer des situations particulières et peuvent fournir des repères pour des soins de soutien supplémentaires.

« En aucun cas, ces applications et ces chatbots ne remplaceront un humain », a-t-elle déclaré. « Nous pensons que le modèle hybride de AI des chatbots et un thérapeute humain seront très prometteurs.