ComArtSci Universitair hoofddocent communicatie Jingbo Meng wilde zien hoe effectief kunstmatige intelligentie (AI) chatbots zouden kunnen zijn bij het leveren van ondersteunende berichten. Dus zette ze het onderzoek op en gebruikte een chatbot-ontwikkelplatform om het uit te testen.

"Chatbots zijn op grote schaal toegepast in klantenservice via tekst- of spraakgebaseerde communicatie", zei ze. "Het is een natuurlijke uitbreiding om na te denken over hoe AI-chatbots een rol kunnen spelen bij het bieden van empathie na het luisteren naar iemands verhalen en zorgen."

Chatten

Begin 2019 begon Meng de effectiviteit van empathische chatbots te beoordelen door ze te vergelijken met menselijke chat. Ze had de groei van digitale apps voor gezondheidszorg en welzijn gevolgd en zag de fenomenale groei van apps die te maken hadden met geestelijke gezondheid. Haar eerdere samenwerking met technische collega's van MSU was gericht op een draagbaar mobiel systeem om gebruikers te detecteren, te volgen en te ondervragen over gedragskenmerken van stress en depressie. De samenwerking inspireerde haar om chatbots te gebruiken die gesprekken met gebruikers initiëren wanneer de gedragsmarkeringen worden geïdentificeerd.

"We voelden dat sommige chatbotcommunicatie zou kunnen werken, andere misschien niet", zei Meng. "Ik wilde meer onderzoek doen om te begrijpen waarom, zodat we effectievere berichten kunnen ontwikkelen voor gebruik in apps voor geestelijke gezondheidszorg."

Meng rekruteerde 278 MSU-studenten voor haar onderzoek en vroeg hen om de belangrijkste stressoren te identificeren die ze de afgelopen maand hadden ervaren. Deelnemers werden vervolgens via Facebook Messenger verbonden met een empathische chatpartner. De ene groep kreeg te horen dat ze met een chatbot zouden praten, een andere groep begreep dat ze met een mens zouden praten. De rimpel? Meng stelde het zo in dat alleen chatbots vragen en berichten afleverden, zodat ze kon meten of deelnemers anders reageerden toen ze dachten dat hun chatpartner een mens was.

Meng varieerde ook het niveau van wederzijdse zelfonthulling die deelnemers zouden ervaren tijdens hun sessies van 20 minuten. Sommige chatbots deelden hun eigen ervaringen om empathie op te wekken. Andere chatbots gingen gewoon in op hun eigen persoonlijke problemen ten koste van het niet valideren van de deelnemers.”

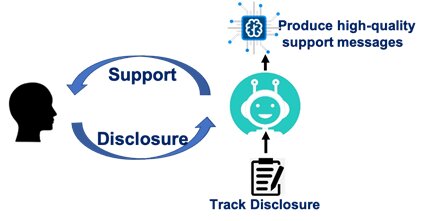

Met uitzondering van de verschillende scenario's voor wederzijdse zelfonthulling, waren de inhoud en stroom van gesprekken precies hetzelfde gescript voor chatbots en voor de waargenomen menselijke chatpartners. Chatbots vroegen deelnemers om stressoren te identificeren. Ze vroegen hoe de deelnemers zich voelden. Ze onderzochten waarom deelnemers dachten dat stressoren hen bepaalde gevoelens gaven. Vervolgens deelden chatbots hun eigen ervaringen.

"Ze waren geprogrammeerd om deelnemers te valideren en te helpen door stressvolle situaties heen te komen", zei ze. "Ons doel was om te zien hoe effectief de berichtgeving zou kunnen zijn."

Ontzorgen

Meng ontdekte dat een deelnemer, of hij nu met een chatbot of met een mens praatte, moest voelen dat de partner ondersteunend of zorgzaam was. Als aan die voorwaarde wordt voldaan, is het gesprek succesvol in het verminderen van stress.

Haar onderzoek onthulde ook dat, ongeacht de boodschap, de deelnemers vonden dat mensen meer zorgzaam en ondersteunend waren dan een chatbot.

Haar scenario's over wederzijdse zelfonthulling vertelden een ander verhaal. Menselijke partners die zichzelf openbaarden - ongeacht of het hun bedoeling was om empathisch te zijn of om alleen maar dieper in te gaan op hun eigen problemen - droegen bij aan het verminderen van stress. Maar chatbots die zichzelf openbaarden zonder emotionele steun te bieden, deden weinig om de stress van een deelnemer te verminderen - zelfs minder dan chatbots die helemaal niets zeiden.

"Mensen zijn gewoon meer herkenbaar", zei Meng. "Als we met een ander mens praten, zelfs als ze onze emoties niet valideren, kunnen we natuurlijker met elkaar omgaan. Chatbots moeten echter explicieter zijn en berichten van hogere kwaliteit verzenden. Anders kan zelfonthulling vervelend en onaangenaam zijn.”

De bron waarnemen

Meng deed en analyseerde onderzoek met Yue (Nancy) Dai, een alumna van het MSU-doctoraatsprogramma Communicatie in 2018 en professor aan de City University of Hong Kong. Hun bevindingen werden gepubliceerd in de Journal of Computer-Mediated Communication.

Meng zei dat de studie onderstreept dat chatbots die worden gebruikt in apps voor geestelijke gezondheid het beste werken als ze worden gezien als een echt zorgzame bron. Ze is van plan het onderzoek op te volgen met aanvullend onderzoek dat onderzoekt hoe berichten kunnen worden ontworpen om de zorgzame factor te vergroten.

Geestelijke gezondheidsapps, zei ze, gaan niet weg en nemen in feite toe in gebruik en beschikbaarheid. Terwijl de meerderheid van de mensen toegang heeft tot een mobiele telefoon, hebben velen niet direct toegang tot een therapeut of ziektekostenverzekering. Apps, zei ze, kunnen individuen helpen bepaalde situaties te beheren en kunnen benchmarks bieden voor aanvullende ondersteunende zorg.

"Deze apps en chatbots zullen in geen geval een mens vervangen", zei ze. “Wij geloven dat het hybride model van AI chatbots en een menselijke therapeut zullen veelbelovend zijn.”