El profesor asociado de comunicación de ComArtSci, Jingbo Meng, quería ver qué tan efectivos podían ser los chatbots de inteligencia artificial (IA) para transmitir mensajes de apoyo. Así que preparó la investigación y usó una plataforma de desarrollo de chatbot para probarla.

“Los chatbots se han aplicado ampliamente en el servicio al cliente a través de la comunicación basada en texto o voz”, dijo. "Es una extensión natural pensar en cómo los chatbots de IA pueden desempeñar un papel en la empatía después de escuchar las historias y preocupaciones de alguien".

Charlarlo

A principios de 2019, Meng comenzó a evaluar la efectividad de los chatbots empáticos comparándolos con el chat humano. Ella había estado siguiendo el crecimiento de las aplicaciones digitales de salud y bienestar, y vio el crecimiento fenomenal de las relacionadas con la salud mental. Su colaboración anterior con colegas de ingeniería de MSU se centró en un sistema móvil portátil para detectar, rastrear y consultar a los usuarios sobre los marcadores de comportamiento de estrés y depresión. La colaboración la inspiró a usar chatbots que inician conversaciones con los usuarios cuando se identifican los marcadores de comportamiento.

"Sentimos que algunas comunicaciones de chatbot podrían funcionar, otras podrían no funcionar", dijo Meng. "Quería investigar más para comprender por qué, de modo que podamos desarrollar mensajes más efectivos para usar en aplicaciones de salud mental".

Meng reclutó a 278 estudiantes universitarios de MSU para su estudio y les pidió que identificaran los principales factores estresantes que habían experimentado en el último mes. Luego, los participantes se conectaron a través de Facebook Messenger con un compañero de chat empático. A un grupo se le dijo que hablarían con un chatbot, otro entendió que hablarían con un humano. ¿La arruga? Meng lo configuró para que solo los chatbots entregaran consultas y mensajes, lo que le permitió medir si los participantes reaccionaban de manera diferente cuando pensaban que su compañero de chat era humano.

Meng también varió el nivel de autorrevelación recíproca que los participantes experimentarían durante sus sesiones de 20 minutos. Algunos chatbots compartieron sus propias experiencias como una forma de evocar empatía. Otros chatbots simplemente expusieron sus propios problemas personales a expensas de no validar a los participantes ".

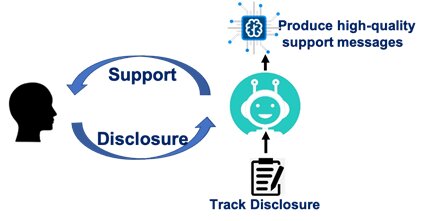

Con la excepción de los diferentes escenarios de autorrevelación recíproca, el contenido y el flujo de las conversaciones se escribieron exactamente igual para los chatbots y para los socios de chat humanos percibidos. Los chatbots pidieron a los participantes que identificaran los factores estresantes. Preguntaron cómo se sentían los participantes. Investigaron por qué los participantes pensaban que los factores estresantes los hacían sentir de cierta manera. Luego, los chatbots compartieron sus propias experiencias.

“Fueron programados para validar y ayudar a los participantes a superar situaciones estresantes”, dijo. "Nuestro objetivo era comprobar la eficacia de los mensajes".

Cuidando

Meng descubrió que, ya sea hablando con un chatbot o con un humano, un participante tenía que sentir que su pareja lo apoyaba o lo cuidaba. Si se cumple esa condición, la conversación logrará reducir el estrés.

Su estudio también reveló que, independientemente del mensaje, los participantes sintieron que los humanos eran más cariñosos y solidarios que un chatbot.

Sus escenarios sobre la autorrevelación recíproca contaron otra historia. Las parejas humanas que se revelaron a sí mismas, independientemente de si su intención era ser empática o simplemente desarrollar sus propios problemas, contribuyeron a la reducción del estrés. Pero los chatbots que se revelaron a sí mismos sin ofrecer apoyo emocional hicieron poco para reducir el estrés de un participante, incluso menos que los chatbots que no dijeron nada en absoluto.

"Los seres humanos son simplemente más identificables", dijo Meng. “Cuando hablamos con otro ser humano, incluso cuando no valida nuestras emociones, podemos relacionarnos de forma más natural. Los chatbots, sin embargo, tienen que ser más explícitos y enviar mensajes de mayor calidad. De lo contrario, la autorrevelación puede ser molesta y desagradable ".

Percibiendo la fuente

Meng realizó y analizó la investigación con Yue (Nancy) Dai, una exalumna de 2018 del programa de doctorado en Comunicación de MSU y profesora de la City University of Hong Kong. Sus hallazgos fueron publicados en el Diario de la comunicación mediada por ordenador.

Meng dijo que el estudio subraya que los chatbots utilizados en aplicaciones de salud mental funcionan mejor cuando se perciben como una fuente verdaderamente solidaria. Ella planea hacer un seguimiento del estudio con investigaciones adicionales que examinen cómo se pueden diseñar los mensajes para aumentar el factor de cuidado.

Las aplicaciones de salud mental, dijo, no van a desaparecer y, de hecho, están aumentando en uso y disponibilidad. Si bien la mayoría de las personas tiene acceso a un teléfono móvil, muchas no tienen acceso inmediato a un terapeuta o seguro médico. Las aplicaciones, dijo, pueden ayudar a las personas a manejar situaciones particulares y pueden proporcionar puntos de referencia para una atención de apoyo adicional.

"De ninguna manera estas aplicaciones y chatbots reemplazarán a un humano", dijo. “Creemos que el modelo híbrido de AI los chatbots y un terapeuta humano serán muy prometedores ".